黄仁勋:供应商对AI芯片预期低迷,但英伟达仍无惧竞争

英伟达首席执行官黄仁勋告诉投资者,尽管竞争对手不断蚕食英伟达的市场份额,而且英伟达的一家主要供应商对人工智能芯片的销售做出了低迷预测,但英伟达仍将是人工智能训练芯片的黄金标准。

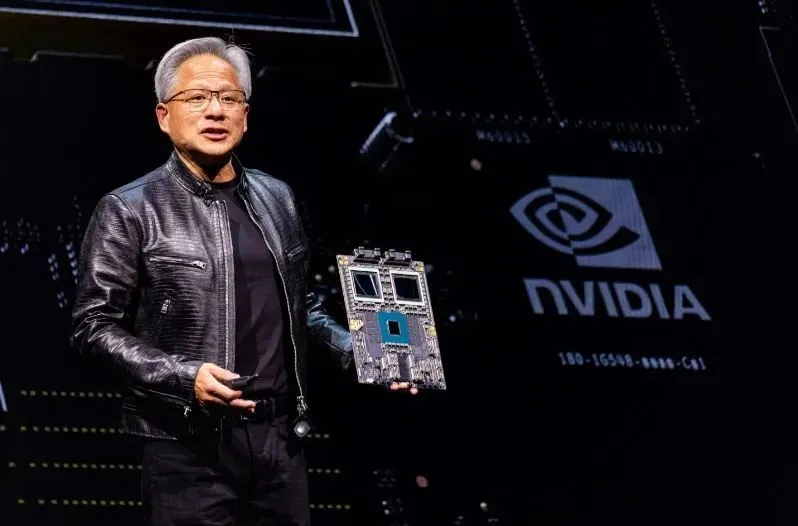

从 OpenAI 到埃隆·马斯克的特斯拉,每个人都依赖 Nvidia 半导体来运行他们的大型语言或计算机视觉模型。黄仁勋在周三的公司年度股东大会上表示,今年晚些时候 Nvidia 的Blackwell系统将推出,这将巩固这一领先地位。

Blackwell于 3 月份发布,是继其旗舰产品 Hopper 系列 H100 芯片之后的下一代人工智能训练处理器——Hopper 系列 H100 芯片是科技行业最珍贵的财富之一,每个芯片的价格高达数万美元。

黄仁勋表示:“Blackwell架构平台很可能成为我们历史上,乃至整个计算机历史上最成功的产品。”

英伟达本月一度超越微软和苹果,成为全球市值最高的公司,这一惊人涨势推动了 今年 标准普尔 500 指数的大部分涨幅。黄仁勋的公司市值一度超过 3 万亿美元,超过整个经济体和 股市,但 由于投资者锁定利润, 其市值出现了创纪录的下跌。

然而,只要英伟达芯片继续成为人工智能训练的基准,就没有理由相信 长期前景 会黯淡,而且这里的 基本面 仍然看起来强劲。

Nvidia 的主要优势之一是其强大的 AI 生态系统, 即 CUDA(计算统一设备架构的缩写)。就像普通消费者不愿意从 Apple iOS 设备切换到使用Google Android 的三星手机一样,一大批开发人员多年来一直在使用 CUDA,他们对此感到非常满意,以至于没有理由考虑使用其他软件平台。与硬件一样,CUDA 实际上已成为自己的标准。

黄仁勋周三补充道:“Nvidia 平台可通过各大云提供商和计算机制造商广泛使用,为开发人员和客户创造了庞大且具有吸引力的使用者基础,这使得我们的平台对客户更有价值。”

美光对下一季度营收的预期不足

人工智能行业最近确实遭受了打击,因为内存芯片供应商美光科技(为 Nvidia 等公司提供高带宽内存 (HBM) 芯片)预测第四财季营收将仅达到市场预期的 76 亿美元左右。

美光科技股价暴跌 7%,远远落后于科技股占比较大的纳斯达克综合指数的微幅上涨。

过去,美光及其韩国竞争对手三星和SK海力士都经历过存储芯片市场常见的周期性兴衰。与图形处理器等逻辑芯片相比,存储芯片长期以来被视为一种商品业务。

但鉴于对人工智能训练所需芯片的需求,投资者的热情也随之高涨。美光的 股价在过去 12 个月内上涨了一倍多,这意味着投资者已经消化了管理层的大部分增长预期。

Deepwater Asset Management 的科技投资者 Gene Munster 表示:“该指引基本符合预期,而在人工智能硬件领域,如果指引符合预期,那就算是有点失望了。动量投资者只是没有看到对这一情况更加乐观的增量理由。”

分析师密切关注对高带宽内存的需求,将其作为人工智能行业的领先指标,因为它对于解决当今人工智能训练面临的最大经济制约因素——扩展问题至关重要。

HBM 芯片解决 AI 训练中的扩展问题

成本并非随着模型的复杂度(其参数数量可达数十亿)而增长,而是呈指数增长。这会导致效率收益随着时间的推移而递减。

即使收入以稳定的速度增长,随着模型的不断进步,亏损也有可能每年激增至数十亿美元甚至数百亿美元。这可能会让任何没有像微软这样的财力雄厚的投资者的公司不堪重负,因为微软有能力确保 OpenAI 仍能“支付账单”,正如首席执行官 Sam Altman 最近所说。

收益递减的一个关键原因是决定 AI 训练性能的两个因素之间的差距越来越大。第一个是逻辑芯片的原始计算能力(以每秒计算的 FLOPS 来衡量),第二个是快速输入数据所需的内存带宽(通常以每秒数百万次传输或 MT/s 来表示)。

由于它们协同工作,因此只扩展其中一个只会导致浪费和成本低效。这就是为什么 FLOPS 利用率(即实际可以发挥多少计算能力)是判断 AI 模型成本效率的关键指标。

明年年底前将全部售完

正如美光 所指出的,数据传输速率无法跟上计算能力的提升。由此产生的瓶颈,通常被称为“内存墙”,是当今扩展 AI 训练模型时固有效率低下的主要原因。

这也解释了为什么美国政府 在决定禁止哪些特定的 Nvidia 芯片出口到中国以削弱北京的人工智能发展计划时,重点关注内存带宽。

美光周三表示,其 HBM 业务已“售罄”,一直持续到下一年度末,比其财年晚了一个季度, 韩国竞争对手SK 海力士也发表了类似言论。

美光周三表示:“我们预计 24 财年 HBM 的收入将达到数亿美元,25 财年 HBM 的收入将达到数十亿美元。”

相关内容

- 2024-12-18 2024年十大科技进步,除了AI还有这九个

- 2024-12-18 AI端侧爆发,桌面机器人迎量产!产业链上市公司加码“抢鲜”

- 2024-12-18 旗舰芯片囤货是对手两倍多,英媒曝英伟达AI芯片最大买家

- 2024-12-17 ASIC大刀砍向GPU,英伟达垄断时代要被终结了?

- 2024-12-17 AI“入侵”生物医药史:从暴力破解到Transformer模型三部曲

点击排行

- 105-17OpenAI多位重量级高管离职,质疑再次涌向Sam Altman

- 203-07ChatGPT-Plus,AI 助手全套开源解决方案,自带运营管理后台,开箱即用。

- 306-22RTranslator: 全球第一个开源实时翻译应用程序

- 410-18诺奖得主哈萨比斯最新访谈:仅仅将AI视作一种技术是错误的

- 505-17马斯克称OpenAI最新模型慢得离谱

- 606-23OpenAI CTO:GPT-5可能会在2025年底或2026年初推出

- 706-23企业家自曝用了ChatGPT后裁员近1/10:管理效率大幅提升

- 805-17GPT-4o被全球网友玩坏了 谷歌:终究是错付了

- 906-23高通开放AI模型,助力开发者打造骁龙X Elite平台智能应用

- 1005-17谷歌Gemini AI 计划为学校提供额外的数据保护和隐私