Meta发布3D Gen AI模型:1分钟内生成高质量3D内容

更新时间:2024-07-03 16:14:16

编辑:管理员

浏览:389

Meta发布3D Gen AI模型:1分钟内生成高质量3D内容

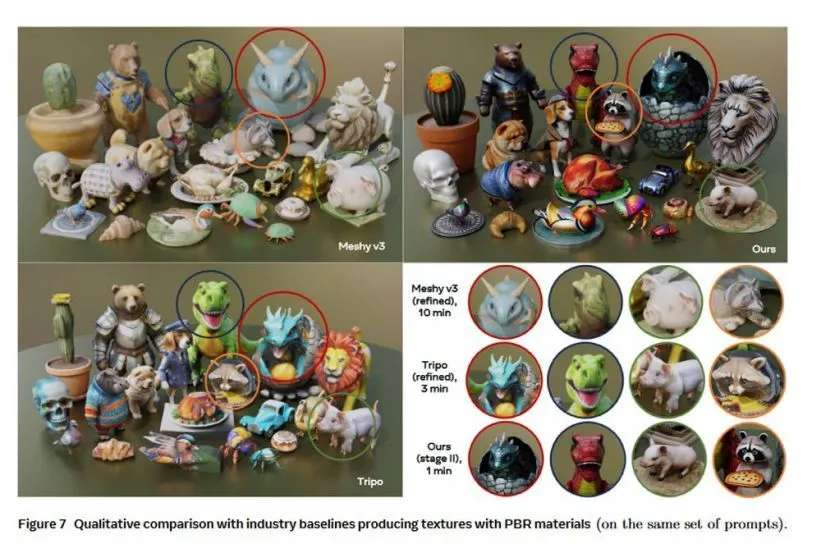

7 月 3 日消息,Meta 公司昨日(7 月 2 日)发布研究论文,介绍了名为 Meta 3D Gen(3DGen)的全新 AI 模型,可以在 1 分钟内基于用户输入的提示词,生成高质量的 3D 内容。

Meta 公司表示 Meta 3D Gen(3DGen)所生成的 3D 内容具备高分辨率纹理和材质贴图,还支持基于物理的渲染(PBR),并能对此前生成的 3D 内容重新再生成新纹理。

IT之家援引论文主要内容,Meta 3D Gen 包含 text-to-3D 生成和 text-to-texture 生成两个主要组件,其工作原理如下:

第一阶段

根据用户提供的文本提示,第一阶段使用 Meta 的三维资产生成模型(AssetGen)创建初始 3D 资产。该步骤生成一个带有纹理和 PBR 材质贴图的 3D mesh。推理时间约为 30 秒。

第二阶段

案例 1:生成更细化的 3D 纹理

根据阶段 1 生成的三维资产和初始文本提示,阶段 2 将为该资产生成更高质量的纹理和 PBR 贴图。它使用 Meta 的文本到纹理生成器 Meta 3D TextureGen。推理时间约为 20 秒。

案例 2:再生成 3D 纹理

给定一个未纹理化的 3D mesh 和一个描述其所需外观的提示。阶段 2 还可以从头开始为该三维资产生成纹理(mesh 可以是以前生成的,也可以是艺术家创建的)。推理时间约为 20 秒。

IT之家附上完整报告链接,感兴趣的用户可以深入阅读。

上一篇:字节、腾讯争夺AI分发权

下一篇:大模型与程序员,谁吃了谁

相关内容

- 2024-11-23 黄仁勋获港科大荣誉博士,演讲大秀中文,称AI可能是人类历史上最重要的技术

- 2024-11-22 第一批用AI的外贸人已经赢麻了

- 2024-11-21 谷歌前CEO改口称美国ai落后中国了

- 2024-11-19 阿里海外,要靠AI打响效率之战

- 2024-11-18 谷歌前CEO:AI性能将继续高速增长,潜在威胁不容忽视

点击排行

- 105-17OpenAI多位重量级高管离职,质疑再次涌向Sam Altman

- 206-22RTranslator: 全球第一个开源实时翻译应用程序

- 303-07ChatGPT-Plus,AI 助手全套开源解决方案,自带运营管理后台,开箱即用。

- 410-18诺奖得主哈萨比斯最新访谈:仅仅将AI视作一种技术是错误的

- 505-17马斯克称OpenAI最新模型慢得离谱

- 606-23OpenAI CTO:GPT-5可能会在2025年底或2026年初推出

- 706-23企业家自曝用了ChatGPT后裁员近1/10:管理效率大幅提升

- 805-17GPT-4o被全球网友玩坏了 谷歌:终究是错付了

- 906-23高通开放AI模型,助力开发者打造骁龙X Elite平台智能应用

- 1005-17谷歌Gemini AI 计划为学校提供额外的数据保护和隐私