王者降临!苹果全家桶接入ChatGPT,重塑iPhone、iPad 、Siri

今天凌晨2点,OpenAI开启了第五天技术直播,宣布苹果的iPhone、iPad 、Mac和Siri可以原生使用ChatGPT。

并且iPhone 16以上的手机可以使用高级视觉功能,而Siri也得到了极大的强化,现在能更深度的理解你提出的问题。

苹果的入局对生成式AI赛道来说影响巨大,凭借其全球数亿用户可以再一次拉升ChatGPT等产品的曝光度和使用范围,一个AI驱动硬件设备时代来临了。

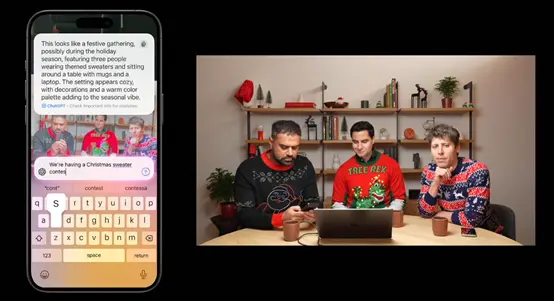

今天的产品发布会基本上都是比较干货的使用案例展示。现在,iPhone 16 的相机可以使用ChatGPT 的高级视觉功能。

当用户拍摄照片或选择相册中的图片后,相机控制功能会对图像进行初步分析,提取图像中的关键元素,如人物、物体、场景等信息。然后,将这些信息传递给 ChatGPT 进行进一步的理解和处理。

例如,ChatGPT 能够识别出照片中的毛衣款式、颜色和图案等特征,并根据用户设定的标准(如趣味性、颜色、亮丽程度等)对毛衣进行排名。同时,ChatGPT 还可以根据图像内容提供相关的建议或信息,推荐与毛衣搭配的配饰或适合该场景的活动等。

在演示环节,ChatGPT特意点评了Sam Altman等人穿的毛衣,并解释每个人的穿搭特色和优势。

Siri 作为苹果移动端最主要的智能语音助手,在理解、生成、执行方面却一直不如意。现在可以和ChatGPT 一起协同工作了,为用户提供更准确、详细的回答。

例如,在组织圣诞派对的场景中,用户可以通过 Siri 向 ChatGPT 询问相关建议,如客人名单、音乐和娱乐安排等,ChatGPT 能够迅速给出一系列实用的想法,极大地提升了用户获取信息和规划活动的效率。

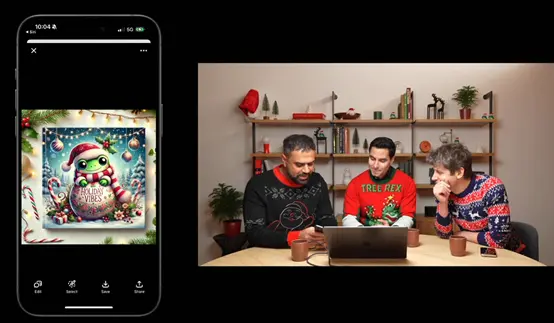

此外,用户现在也可以使用文生图功能,让ChatGPT理解并尝试生成相应的描述,例如,让它生成一张圣诞节的图片。

ChatGPT最强、基本的功能当然是文本生成与理解,现在MAC系统中可以原生使用它了。

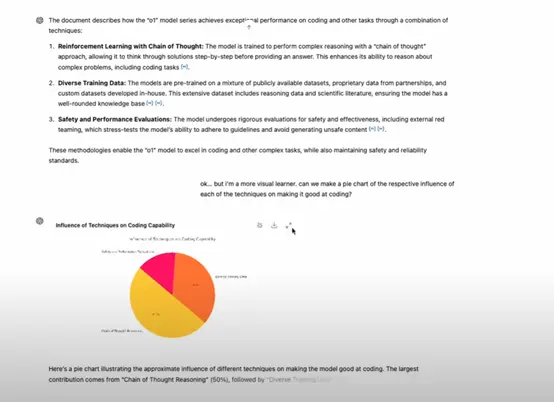

在演示环节,特意用ChatGPT解读了49页o1模型的技术报告。ChatGPT 能够准确识别文档中提到的各种编码技术及其应用场景,并详细阐述了这些技术如何协同工作以提高模型的编码能力。

此外,ChatGPT能根据用户要求制作饼图来展示不同技术对编程能力的影响程度,展示了强大的数据可视化的能力。

ChatGPT也能够提供数据处理和分析的思路,帮助用户更好地理解数据之间的关系,为进一步的可视化操作提供了基础。例如,ChatGPT 可以计算出每种技术在文档中被提及的频率或重要性权重,并将这些数据以适合制作饼图的格式呈现给用户。

苹果太需要这个了。

OpenAI+ Apple = 梦想成真!

ChatGPT绝对是我在笔记本上使用最多的应用。我在手机上用得不太频繁,但在笔记本上几乎每天都用。太厉害了!

这是直接让ChatGPT取代Siri了

今天的节目突出了苹果智能的不足之处,大部分工作都依赖于ChatGPT。

现在看来不得不买iPhone16了。

相关内容

- 2024-12-12 OpenAI ChatGPT全球范围内宕机,苹果iOS 18.2 Siri受牵连

- 2024-12-12 苹果股价续创历史新高 消息称正与博通合作研发AI芯片

- 2024-12-08 OpenAI ChatGPT o1模型被曝会自我复制,还会说谎

- 2024-12-05 苹果百度AI合作遇阻,到底是什么原因?

- 2024-12-05 苹果与百度合作开发中国版AI功能遇阻,或影响iPhone销量

点击排行

- 105-17OpenAI多位重量级高管离职,质疑再次涌向Sam Altman

- 203-07ChatGPT-Plus,AI 助手全套开源解决方案,自带运营管理后台,开箱即用。

- 306-22RTranslator: 全球第一个开源实时翻译应用程序

- 410-18诺奖得主哈萨比斯最新访谈:仅仅将AI视作一种技术是错误的

- 505-17马斯克称OpenAI最新模型慢得离谱

- 606-23OpenAI CTO:GPT-5可能会在2025年底或2026年初推出

- 706-23企业家自曝用了ChatGPT后裁员近1/10:管理效率大幅提升

- 805-17GPT-4o被全球网友玩坏了 谷歌:终究是错付了

- 906-23高通开放AI模型,助力开发者打造骁龙X Elite平台智能应用

- 1005-17谷歌Gemini AI 计划为学校提供额外的数据保护和隐私