Nature:警惕!AI让人类“自大”,或使科学缺乏创新

近年来,人工智能(AI)技术在科学研究领域中的应用与影响日益显著。从生物医学、材料学、到天文学等学科,AI4Science 正改变着科学研究的方式,加速科学研究。

AI 通过提供大规模数据分析、模拟实验环境、优化研究过程等功能,为科学家们提供了前所未有的支持和帮助,也确实将科学研究推向了一个新的阶段。

然而,AI 在为科研带来更多可能性的同时,也引发了许多问题。

来自耶鲁大学和普林斯顿大学的研究团队认为,在科学研究中,AI 可能会造成知识生产的单一性,即科学的单一文化(scientific monocultures)。

具体来说,在这种文化中,某些类型的方法、问题和观点主导了其他方法,使科学缺乏创新性,更容易出错。

同时,AI 提出的解决方案也可能掩盖了我们的认知局限性,使我们容易产生一种错觉,即我们认为自己对世界的了解比实际情况要多。

因此,科学家需要审慎考虑 AI 在科学研究中的潜在影响,从而负责任地进行知识生产。

相关研究论文以“Artificial intelligence and illusions of understanding in scientific research”为题,已发表在科学期刊 Nature 上。

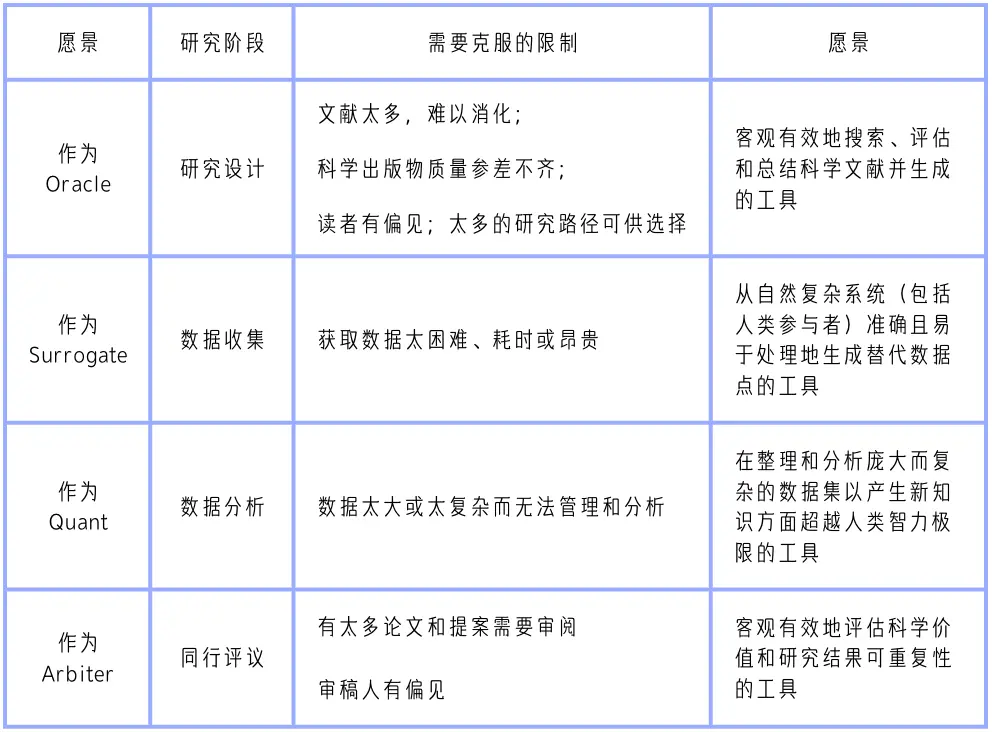

该论文从大量与 AI4Science 相关的文献中,提炼出了 AI 的四大应用愿景——智囊团(Oracles)、代理人(Surrogates)、量化分析师(Quants)和裁决者(Arbiters),并分别讨论了 AI 在科学研究中的应用和影响。

表|科学研究中的 AI 愿景。通过分析最近有关 AI 改善跨科学学科知识生产潜力的出版物,得出以上四种类型。纳入的论文要么使用“AI”这个通用短语,要么提到 AI 概念之下的特定方法,最常见的是机器学习、自然语言处理和大型语言模型。该表总结了愿景如何响应不同的研究阶段,以及对科学能力和效率的感知限制。

人类科学家为何信任AI?

近年来,AI 在科学研究中的应用日益广泛,其提供的解决方案被认为能够彻底改变科学研究方法。

但 AI 何以获得科学家的信任呢?

首先,AI 工具不仅被视为工具,更被看作是研究中的合作者,能够提供超越人类限制的解决方案和见解。这种认知增强了科学家对 AI 的信任,因为他们将这些工具视为知识生产中的伙伴。

其次,AI 工具被认为具有增强其可信度的特质,如客观性、深度理解能力以及提供令人满意的解释能力。这种描绘使得 AI 工具在某些情况下比人类更值得信赖。

第三,AI 工具提供的解决方案符合人们对简单、广泛、简化和量化解释的偏好,进而增强了对理解的感知。

然而,将 AI 整合到科学研究中也存在认知风险,尤其是认知理解的错觉形式。

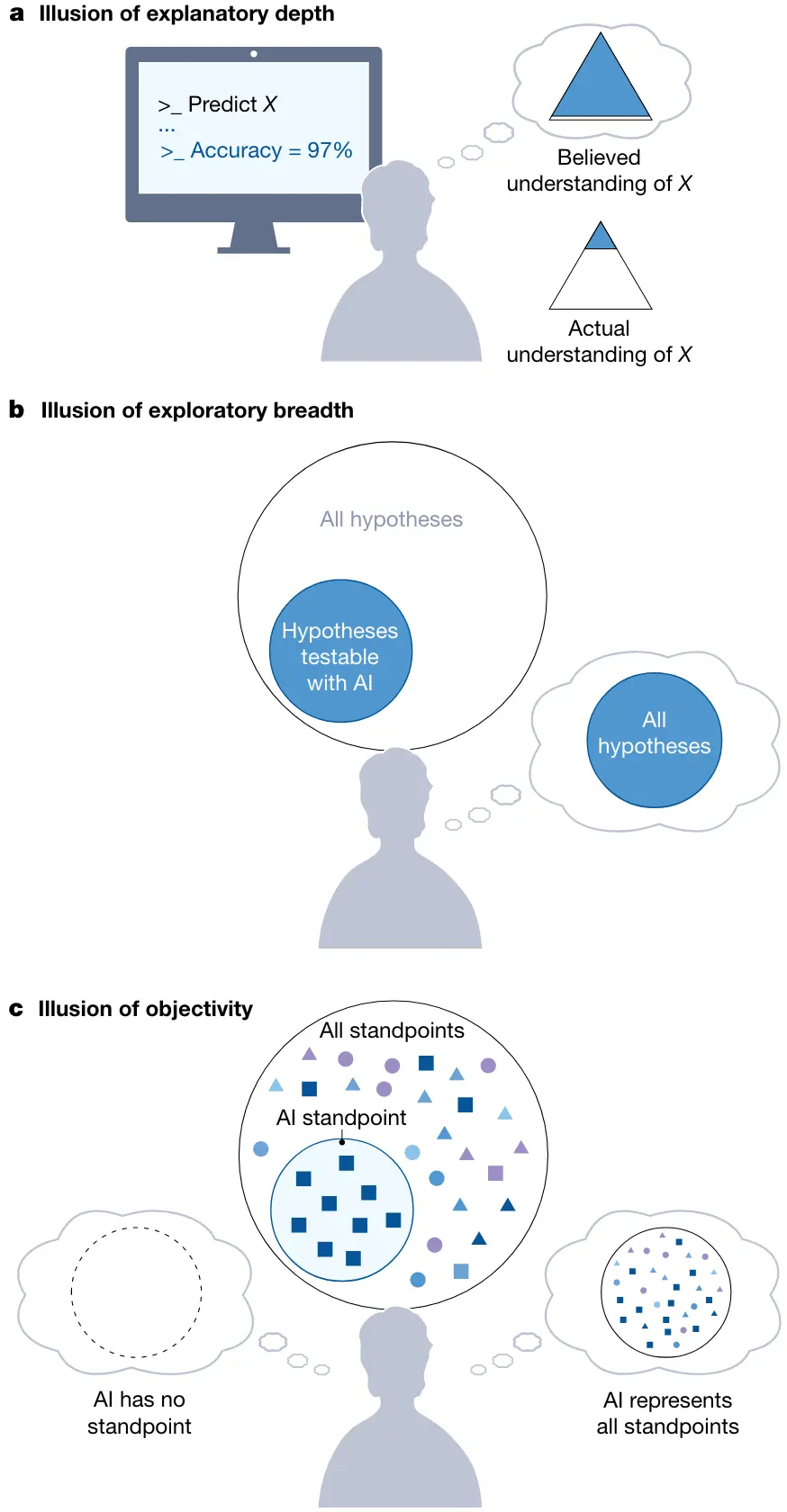

图|AI 驱动的科学研究中的理解错觉。

如上图 a 所示,使用 AI 工具进行研究的科学家可能会产生解释深度的错觉。在示例中,一位科学家使用 AI Quant 对现象 (X) 进行建模,并相信他们对 X 的理解比实际更深入。

在图 b 中,在单一的认知文化中,科学家很容易产生探索广度的错觉,他们错误地认为自己正在探索所有可检验假设的空间,而实际上他们正在探索可以用 AI 工具检验的更狭窄的假设空间。

另外,如图 c,在知识者单一文化中,科学家很容易产生客观性错觉,他们错误地认为 AI 工具没有立场或能够代表所有可能的立场使用人类参与者进行研究的替代者),而 AI 工具实际上嵌入了训练数据和开发人员的观点。认知理解的错觉发生在个体高估自己的理解程度时,将 AI 工具或其他社区成员的知识和能力误认为自己的。这种现象可能导致科学论断中的错误和过度乐观,特别是当 AI 工具在专家领域之外使用时。

AI4Science的未来,一切向好吗?

由于 AI 工具看似可信且承诺提升研究的质量和数量,因此依赖这些工具的研究可能会大幅增加。目前,关于 AI 的引用在出版物和专利中在逐渐增多,并且使用 AI 工具的论文在学科内外的引用都呈现出增加的趋势。

如果这个趋势持续发展,那么当 AI 辅助研究逐渐主导知识生产,会有哪些认知风险?

文中给出了一个观点:科学可能会形成单一文化。

作者用了一个类比来说明这一点:在农业中,单一文化是一种在同一片土地上只种植一种作物的做法。这种做法提高了效率,但也使作物更容易受到害虫和疾病的侵害。

文章认为,AI 工具所提供的效率可以促进科学单一文化的发展,其中某些形式的知识生产主导了其他所有形式。它们可以通过两种不同但相辅相成的方式实现。

首先,通过优先考虑最适合 AI 辅助的问题和方法(知识生产的单一文化)。

其次,通过优先考虑 AI 能够表达的观点类型(知识所有者的单一文化)。

就像植物单一文化更容易受到害虫和疾病的侵害一样,科学单一文化使我们对世界的理解更容易出现错误、偏见和错失创新的机会。

当新工具和技术产生时,科学家总是倾向于迅速利用它们的优势。然而,AI 工具被预测将在各个领域得到广泛应用,成为超级合作者融入到知识社区中,这样的风险可能会变得尤其严重。

除了威胁科学的蓬勃发展外,知识生产的单一文化还会产生认知理解错觉。在这些错觉中,科学家错误地认为,AI 工具推进了人类对科学的理解,而不是意识到,这些工具实际上缩小了科学知识生产的范围。

了解风险,是应对风险的关键一步。为了减轻 AI 在知识生产中应用的风险,人类需要增强对科学单一文化的认知风险的理解,以及对认知错觉的感知。

事实上,AI 在科学中的应用确实让所有人兴奋,比如 AI 化学家加速催化研究(点击查看详情),生成式 AI 助力碳捕集(点击查看详情)等等。

然而,在 AI4Science 走得更远之前,科学家们必须考虑到 AI 的技术限制和潜力,以及它对科学知识生产社会实践的影响。

AI 辅助科学研究也许预示着这样一个未来,其中不仅参与者缺乏多样性,而且追求的研究主题也缺乏多样性。它们还引发了认知理解的错觉,阻止我们意识到我们的视野已经变窄。

尽管 AI 在科学中的广泛应用是不可避免的,但科学家,除了进行知识生产外,还有责任决定事物的发展方式。

论文链接:

https://www.nature.com/articles/s41586-024-07146-0

相关内容

- 2024-11-23 黄仁勋获港科大荣誉博士,演讲大秀中文,称AI可能是人类历史上最重要的技术

- 2024-11-22 第一批用AI的外贸人已经赢麻了

- 2024-11-21 谷歌前CEO改口称美国ai落后中国了

- 2024-11-19 阿里海外,要靠AI打响效率之战

- 2024-11-18 谷歌前CEO:AI性能将继续高速增长,潜在威胁不容忽视

点击排行

- 105-17OpenAI多位重量级高管离职,质疑再次涌向Sam Altman

- 206-22RTranslator: 全球第一个开源实时翻译应用程序

- 303-07ChatGPT-Plus,AI 助手全套开源解决方案,自带运营管理后台,开箱即用。

- 410-18诺奖得主哈萨比斯最新访谈:仅仅将AI视作一种技术是错误的

- 505-17马斯克称OpenAI最新模型慢得离谱

- 606-23OpenAI CTO:GPT-5可能会在2025年底或2026年初推出

- 706-23企业家自曝用了ChatGPT后裁员近1/10:管理效率大幅提升

- 805-17GPT-4o被全球网友玩坏了 谷歌:终究是错付了

- 906-23高通开放AI模型,助力开发者打造骁龙X Elite平台智能应用

- 1005-17谷歌Gemini AI 计划为学校提供额外的数据保护和隐私