最近更新

- 104-19踏上青云路梁健卷三(完结)下载

- 204-19踏上青云路梁健卷二下载

- 304-19踏上青云路梁健卷一下载

- 404-19我有一剑 > 第八百零八章:稳!

- 504-19我有一剑 > 第八百零七章:正经的那种!

- 604-19我有一剑 > 第八百零六章:大伯好!

- 704-19我有一剑 > 第八百零五章:谁在言无敌?

- 804-19我有一剑 > 第八百零四章:杀疯了!

- 904-19我有一剑 > 第八百零三章:有请先祖!

- 1004-19我有一剑 > 第八百零二章:上啊!打他!

推荐文章

ChatGPT-Plus,AI 助手全套开源解决方案,自带运营管理后台,开箱即用。

ChatGPT-Plus,AI 助手全套开源解决方案,自带运营管理后台,开箱即用。

生死关头,老婆选择白月光(一)

我女儿死了。 大巴车坠江,她当着我的面死在冰冷的江水里。 救援队队长老婆也在现场,却在忙着救后排的初恋父女。 女儿满脸惊恐在江水里挣扎,一遍遍重复:“妈妈救我!” 可直到她沉入江水,纪半夏都不曾分给她一个眼神。 女儿葬礼那天,我给她打电话,打了十几通才有人接。 “阿宇跟安安父女俩落水感冒低烧,现在还在输液,你能不能别不知轻重瞎闹腾?!” 她不耐烦地交代一句,把我拉黑了。

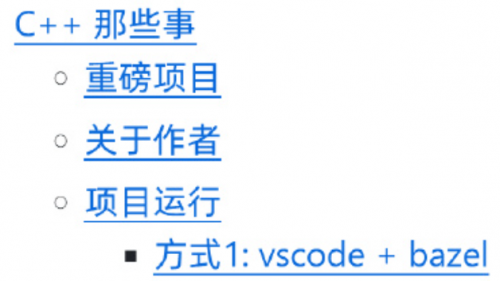

C++那些事:适合初学者从入门到进阶的仓库

C++那些事:适合初学者从入门到进阶的仓库

奥特曼:GPT-5的能力提升幅度将超乎人们的想象...

奥特曼:GPT-5的能力提升幅度将超乎人们的想象...

网文圈

- 2024-02-23 生死关头,老婆选择白月光(一)

- 2024-04-18 拆迁骗局(三)

- 2024-04-18 拆迁骗局(二)

- 2024-04-18 拆迁骗局(一)

- 2024-04-18 为了留住我,妻子竟想烧死我(三)

- 2024-04-18 为了留住我,妻子竟想烧死我(二)

- 2024-04-18 为了留住我,妻子竟想烧死我(一)

- 2024-04-15 为救白月光,律师妻子把我送进监狱(二)

- 2024-04-15 为救白月光,律师妻子把我送进监狱(一)

- 2024-04-15 人性潜规则

技术圈

- 2024-03-07 ChatGPT-Plus,AI 助手全套开源解决方案,自带运营管理后台,开箱即用。

- 2024-03-03 看完马斯克控诉OpenAI的万字报告,感觉他可能被骗惨了

- 2024-04-19 钉钉宣布正式上线 AI Agent Store

- 2024-04-19 有关LLAMA-3、大模型开源与闭源以及合成数据的一些个人看法@张俊林say

- 2024-04-19 Meta发布Llama 3,加强与OpenAI和Google人工智能大战

- 2024-04-19 Video2Game,通过单个视频生成实时、交互式、逼真且与浏览器兼容的游戏环境

- 2024-04-19 开源大模型Llama 3来了,能干得过GPT-4么?

- 2024-04-18 电子书《通过例子学 Rust 》中文版

- 2024-04-18 一款基于 LLM 大语言模型的知识库问答系统:MaxKB

- 2024-04-18 电子书《AI系统 & 深度学习系统》