在iOS 18之前,带你盘点苹果10+个与“AI”相关的软件、硬件_tiknovel-最新最全的nft,web3,AI技术资讯技术社区

在iOS 18之前,带你盘点苹果10+个与“AI”相关的软件、硬件

如果说 2024 年有什么真正的热点话题,AI 可能是当之无愧的热搜第一名。OpenAI 的 ChatGPT 和 Sora、微软的 Copilot、谷歌的 Gemini…… 基于大语言模型(LLM)的生成式 AI 工具层出不穷,迭代速度之快让人应接不暇。

不过对于 Apple 来说,追随 LLM 的脚步似乎并没有那么快。相比 ChatGPT,现如今 Siri 的表现只能说是差强人意——几乎为 0 的上下文理解能力,常常遇到互联网连接问题,语音识别也不够准确。加上这两天 iOS 18 将集成 ChatGPT 的传闻已经满天飞了,Apple「看起来」已经在人工智能领域落后一大截了。

虽说从 2011 年发布 Siri 开始,Apple 对人工智能的探索就一直没有中断,系统中集成了相当多的人工智能相关的功能。但在生成式 AI 如此火爆的 2024 年,Apple 的表现并不突出。相比于一年前绝口不提 AI 的场景,Apple 已经在最近两场发布会里已经尽可能多得提到了 AI。

今天的文章就来盘点一下 Apple 近年来发布会上提到的与人工智能相关的软硬件系统与功能,为一个月后「Absolutely Incredible」的 WWDC 2024 准备一些开胃菜。

01

神经网络引擎:「设备端智能」的硬件基础

Apple 开发的神经网络引擎能够加速特定机器学习模型的处理计算,效率比 CPU 和 GPU 更高,被广泛用于 iPhone、iPad、MacBook 甚至 Apple Watch 等设备。Apple 系统平台的许多人工智能功能,例如设备端 Siri、听写、自动纠错、Animoji 动话表情、计算摄影等,都依赖神经网络引擎在设备本地实时加速运行,而不会影响系统整体的响应速度。通过 Core ML,第三方开发者也可以利用设备上的神经网络引擎加速机器学习计算。例如,App Store 有不少在本地运行的文本生成图像应用。

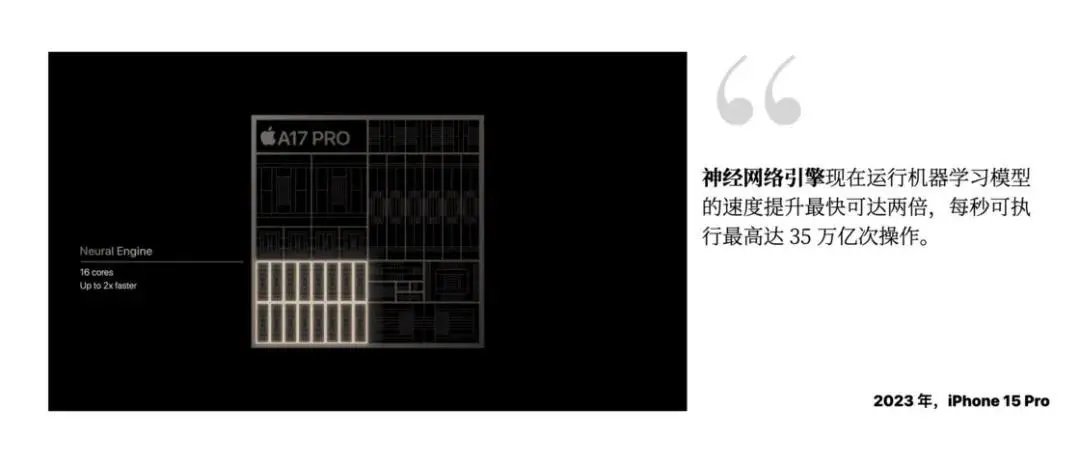

随着 Apple 平台的功能对智能的要求越来越高,设备也配备的神经网络引擎也越来越快。iPhone X 和 iPhone 8 的 A11 中的双核神经网络引擎每秒运行 6000 亿次运算,到如今 iPhone 15 中 A17 PRO 可以每秒运行 35 万亿次操作。神经网络引擎无疑是 Apple 为其「设备端智能」所搭建的重要硬件「基础设施」。正因如此,它也从未缺席任何一场 Apple 的硬件发布会,每次在谈到处理器性能时,也都会带上它:

本文所提到的智能功能,都会在一定程度上依赖神经网络引擎在设备本地运行。

02

相机中的智能

相机定义了现代智能手机的核心体验之一。除了镜头、感光元件和处理器外,iPhone 拍摄照片的过程中还涉及大量设备端智能。镜头和传感器的数据需要经过一系列计算,才能最终呈现在人们眼前。照片拍摄完成后,还有许多与机器学习相关的功能进行人脸识别和分类、生成回忆、自动选择壁纸、提取关键信息等。

▍iPhone 计算摄影

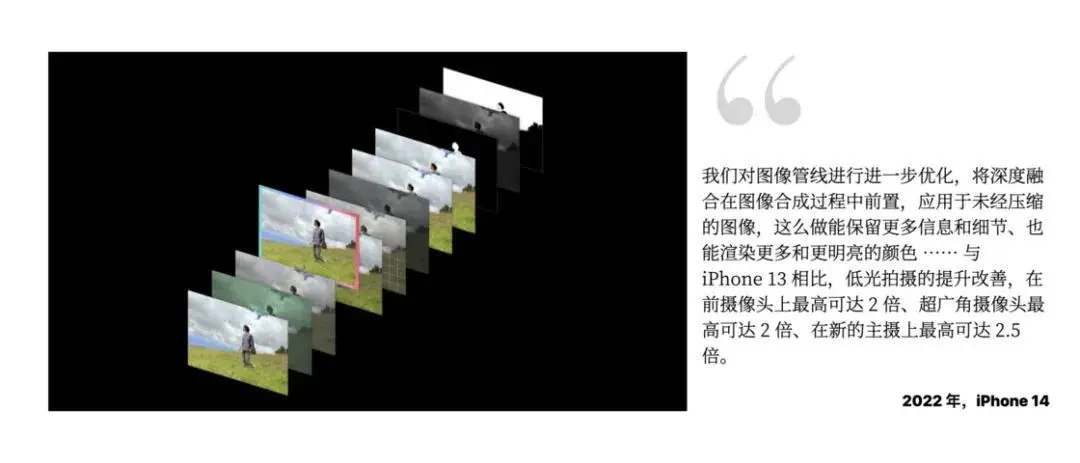

Deep Fusion 最初推出于 iPhone 11 系列,通过机器学习模型进行多达 9 帧的图像合成,从而提升低光状态下的照片品质、降低噪点等。这是 iPhone 计算摄影的重要功能,每年都会更新。例如,iPhone 14 系列中的深度融合功能获得了图像管线优化。

然而,Deep Fusion 是一项默认开启且无法关闭的系统功能。如果使用 Apple 设备自带的相机 app,Deep Fusion 会自动开启并对每一张照片进行处理。不少用户反馈,经过 Deep Fusion 处理的照片看起来对比度过于强烈、过度锐化。

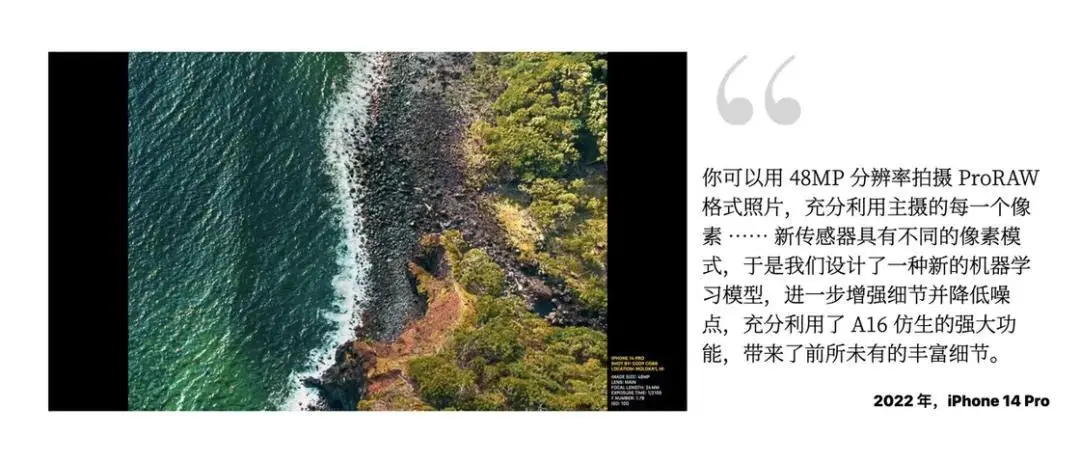

Apple ProRAW 随着 iPhone 12 Pro 的发布而推出,它结合了标准 RAW 格式的信息与 iPhone 计算摄影的照片处理,给予用户更大的编辑空间。在 iPhone 14 Pro 上,用户可以利用全新的主摄拍摄 4800 万像素的 ProRAW 照片,并结合 iPhone 的机器学习功能,获得更高的照片细节。

人像模式是另一项 iPhone 的计算摄影功能,通过摄像头获取的深度信息经过机器学习模型计算,突出摄影主体并模糊背景。在 iPhone 15 系列上,用户无需手动打开人像模式,只要 iPhone 检测到画面中有人物或宠物,系统会自动收集并计算深度数据,提供后期调整是否使用人像模式的选项。尽管人像模式已经推出多年,但机器学习得到的效果有时还是不够自然,常常虚化掉一些主体边缘的细节,特别是用它拍静物时。

与此类似,与深度信息相关的机器学习也已经介入了视频拍摄领域,随 iPhone 13 Pro 发布的「电影模式」就是一例:

综上所述,Apple 认为计算摄影具有非常强的机器学习属性,也是 Apple 每年重点更新的方向。这些技术也被应用到其他设备上,例如 Mac 和 Studio Display 的摄像头,现在会利用 Apple Silicon 的图像信号处理器和神经网络引擎提升画质。

▍Visual Lookup 与实况文本

Visual Lookup 是 Apple 在 WWDC 2021 上推出的照片主体识别功能,识别后,只需要通过聚焦搜索查找关键词,就可以直接找到相关的照片。例如,在搜索时输入「手机」,照片 app 就会自动列出已识别出包含手机的照片。在 WWDC 2022,Apple 还更新了提取主体功能。

相关功能还被用在了 Apple TV 和 HomePod 上,通过 HomeKit 安全视频功能,可以识别家门口的 HomeKit 摄像头看到了什么信息,并发出提示通知。

实况文本是另一项在 WWDC 2021 上推出的功能,它能够识别相机画框或系统内图片(包括网页上的图片、相册中的照片、截屏、访达中的 PDF 文件等)中包含的文本、网址、电话、地址等信息。在 WWDC 2022 上,实况文本还支持视频中任意暂停帧上的信息识别。我常常在 Mac 上使用这项功能,尤其是在阅读一些没有文字信息的 PDF 文件时。整体可用性尚可,识别英语的准确率高于中文,印刷体的识别准确率高于手写体。这项功能虽然使用了机器学习,但基于 Intel 芯片的 Mac 也可以使用。

此外,对照片的分析处理也应用到了系统的其他方面,例如照片回忆与智能建议。它们会利用 Visual Lookup 提供的照片中暗含的场景信息,如旅行、生日派对、宠物、聚餐等,并将照片自动剪辑成带有配乐的短视频。短视频的生成也包含一些机器学习功能,会根据照片和视频的信息以及歌曲的节奏自动调整效果。

03

输入方式的智能

输入文字也是交互设备的基本操作。除了直接通过键盘输入文字外,还可以使用听写和扫描等方式输入。然而,无论使用哪种输入方式,都离不开智能技术的应用——听写涉及语音转文字的识别,键盘输入涉及自动纠正文本和文字预测,扫描则涉及对图片信息的提取。近些年的 WWDC,Apple 都会着力优化文本输入体验。

▍听写

从 iOS 5(2011 年)开始,听写功能就已经内置于 iPhone,当时听写需要完全通过互联网进行处理;如今,听写功能已经可以完全在设备端运行,在输入文字之外还可以输入 emoji,听写时也可以继续用键盘输入文字。大多数情况下,新版听写的准确率都还不错,但语气词比较多的时候,听写也会出现问题,还是需要人工编辑下的。

WWDC 2023 则提到新的 Transformer 模型让听写更加准确 —— 听写是在 Apple Watch 和 Apple Vision Pro 等可穿戴设备上输入文本的一个非常重要且自然的途径,听写的准确率也能够在很大程度上决定使用这两款设备的日常体验如何。

▍自动纠正与输入实时预测

对于直接用键盘输入,WWDC 2023 介绍了优化后的自动纠正功能和输入实时预测功能。自动纠正功能不仅能够纠正用户可能拼错的词语,还能猜测用户在打字时按下的具体键(包括滑行输入时判断的音节,以及 Apple Watch 上的全键盘)。

输入实时预测则能够根据用户个人的词汇表达风格,自动弹出或补全词语。一般来说,这可以预测下一个词,或者帮助你补全一个不确定怎么拼写的长单词。实际体验中,输入实时预测功能在最近几个版本中经常会「纠正」出一些奇怪的词组出来,有的时候我都要怀疑是不是我打错了。

很奇怪的输入预测

Apple 机器学习研究网站上有不少跟 Transformer 模型等有关的研究成果,也会披露一些目前已经在系统中出现的技术的背景细节。例如,如何快速高效准确地生成文本段落、Siri 如何通过语音触发、多模态的大语言模型等等。说不定在下一届 WWDC 上,一些成果就会变成系统中集成的功能。

04

Apple Watch 的机器学习

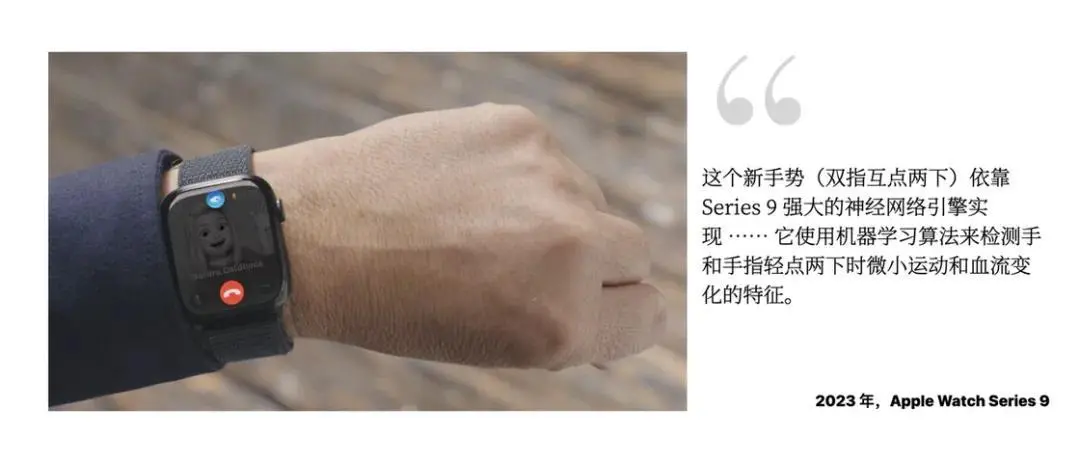

2023 年发布的 Apple Watch Series 9 和 Apple Watch Ultra 2 配备了 S9 芯片,内含 4 核神经网络引擎,这是 Series 9 一系列新功能的基础,包括设备端 Siri、听写和双指互点两下手势。此外,Apple Watch 上还有一系列与运动健康相关的功能也涉及机器学习,例如运动检测和睡眠阶段检测等。

▍系统功能:设备端 Siri、智能叠放、手势

得益于 Apple Watch Series 9 的四核神经网络引擎,不少机器学习任务可以在 Apple Watch 本地更高效地运行。Siri 可以在设备端执行,无需互联网连接,因此响应速度更快,还可以在本地处理用户的健康数据并给出相关回答。例如,除了天气和计时器等功能外,还可以在 Apple Watch Series 9 上询问 Siri 自己前一天的睡眠情况、心率情况等。

Apple Watch Series 9 还支持「双指互点两下」手势,可以通过这个手势来操作 Apple Watch 当前界面上的主要操作,例如接听电话、开启计时器、显示智能叠放等。

watchOS 10 的智能叠放小组件功能也利用机器学习自动建议当前位于最顶部的小组件。每次在表盘上转动数码表冠,都能看到最及时的信息,例如即将开始的会议日程、当前播放中的歌曲等。

▍运动与健康:运动检测、睡眠监测

除了系统相关的功能,Apple Watch 的运动与健康功能也离不开智能技术的参与。例如,2022 年更新的 watchOS 9 增加了对跑姿测量的新指标,其中也包含机器学习成分。

涉及运动健康相关的功能,Apple 也常提到相关模型训练。例如,watchOS 9 的睡眠阶段功能参考了不同人群的睡眠阶段临床研究,并利用设备端机器学习实现。然而令人不解的是,Apple Watch 上的睡眠追踪功能似乎并不自动监测用户是否入睡,而是通过睡眠定时功能开启,用户只能获知在睡眠专注模式期间的睡眠阶段情况;小睡、闹钟关闭后的睡眠都不会继续跟踪。

▍安全功能:摔倒检测、车祸检测

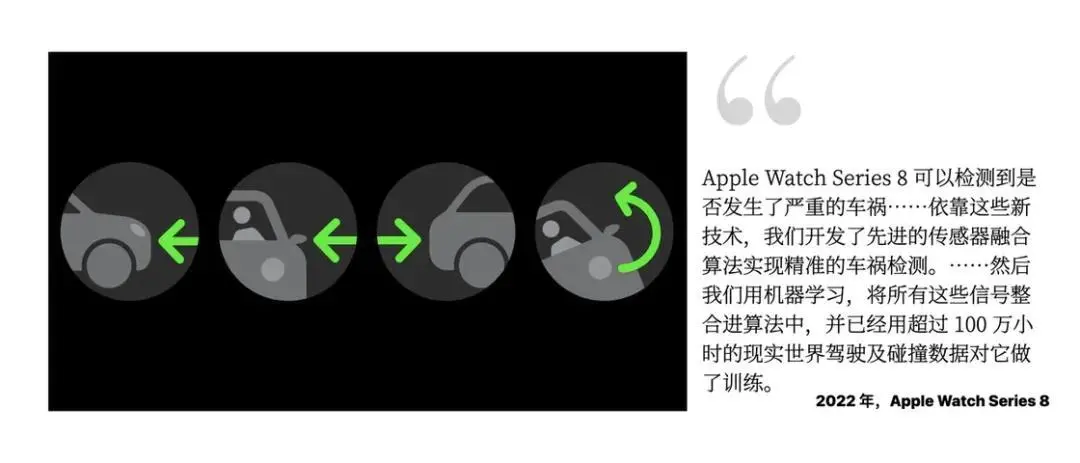

iPhone 和 Apple Watch 还有一些安全功能,例如 Apple Watch 的摔倒检测(在 Apple Watch SE、Apple Watch Series 4 或更新机型上可用,我上次在溜冰场触发了这个功能),也是基于对相关过程的研究分析并形成机器学习模型的。2022 年,Apple 发布了 iPhone 和 Apple Watch 的车祸检测功能,这个功能背后也有机器学习的影子。

▍辅助功能背后的人工智能

在 Apple 设备上还有不少辅助功能,帮助在某些知觉或功能方面有障碍的人士更好地使用现代科技,例如我们熟知的放大镜、VoiceOver 屏幕阅读器、AirPods 助听器等。其中也有一些辅助功能涉及到 Apple 设备的神经网络引擎和设备端智能,例如创建个人语音、声音识别等。

个人声音是一项辅助功能,通过对 150 个用户短语录音的分析,iPhone 或 iPad 可以在设备端创建拟合个人声线的合成声音。在进行 FaceTime 通话、打电话、使用辅助交流 App 以及面对面交谈时,用户可以让系统使用仿真语音朗读,目前支持英语。对于面临失语风险的人来说,这项功能可以帮助他们保存自己的声音,并与他人交流。

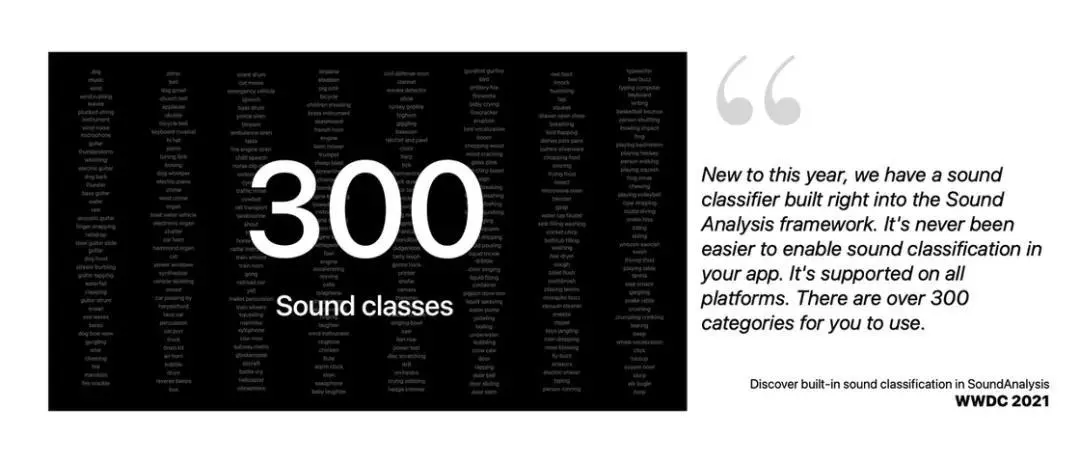

声音识别 (SoundAnalysis) 是 WWDC 2021 推出的一套框架,内置了 300 多种声音类别的分类数据,开发者可以直接在 app 中调用,系统会通过麦克风对声音进行识别。在 iOS 中,基于这个框架,Apple 在辅助功能中加入了声音识别功能,可以识别环境中的各类声音,例如门铃声、警报器声、猫狗叫声等,还可以学习一些特定类别的声音——这对听障人士提供了一定的帮助。

▍写在最后:Apple 的 AI 野心

近期有关 Apple 可能与 OpenAI 等开展合作、WWDC 将重点提升 Apple 平台的 AI 能力等等相关的传闻不断。我也在思考,在生成式 AI 的这股大潮中,Apple 到底会何去何从呢?

从这篇文章,我们看到 Apple 有深厚的机器学习研究和应用基础。然而,现如今较大的 LLM 模型似乎已经复杂到在设备上直接处理不可能的地步,它是否还能坚守自己「设备端智能」的价值观?它又会如何将有更强大能力的 AI 工具带入自己的软件平台?

或许答案要等 6 月 10 日 WWDC 2024 才能见分晓了。

Prev Chapter:亚马逊暂停采购英伟达“超级芯片” 原因竟是升级太快

Next Chapter:微软CEO辣评GPT-4o:不要将AI拟人化,它只是一种工具

评论区

- 这篇文章还没有收到评论,赶紧来抢沙发吧~

【随机内容】

-

Martial God Asura Chapter 2001 - Two Armies Joining Hands

2024-06-10 -

Nine Star Hegemon Body Arts Chapter 1035

2024-11-08 -

Martial God Asura Chapter 5096: The Truth

2024-11-09 -

Unrivaled Medicine God Chapter 257 - True Intent!

2024-11-20