跨越AGI,Ilya官宣创业!我要的是“核安全”,SSI剑指安全超级智能_tiknovel-最新最全的nft,web3,AI技术资讯技术社区

跨越AGI,Ilya官宣创业!我要的是“核安全”,SSI剑指安全超级智能

炸裂!OpenAI真正的灵魂人物Ilya,刚刚官宣了自己出走OpenAI后要创建的新公司——SSI,也即安全超级智能。好家伙,这是直接跨过AGI了,Ilya手里究竟捂着什么前沿研究技术?网友们激动得奔走相告,更有大佬在评论区留言:请收下我的赞助!

出走36天后,Ilya终于官宣了自己的下一步动向:创建新公司,剑指安全超级智能!

是的,从名字就可以看出,这个新公司SSI的核心,就是Safe SuperIntelligence。

才7小时,就迎来近2w的点赞

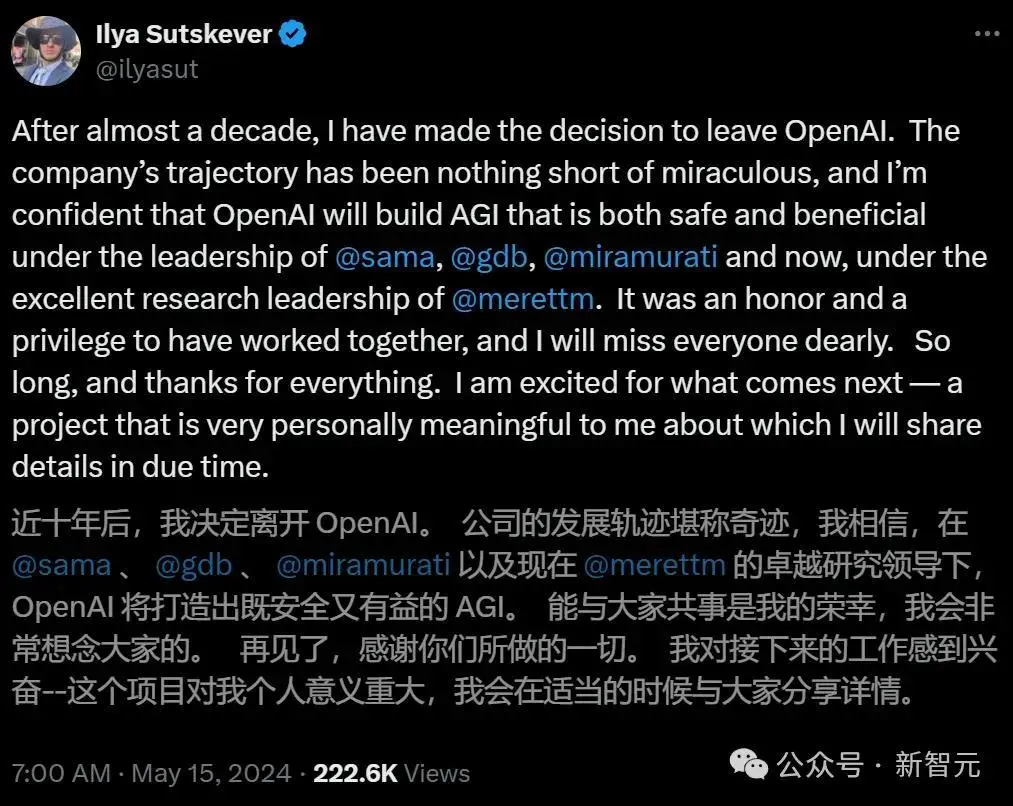

5月15日,Ilya发文称,自己将离开工作近十年的OpenAI,并祝愿前公司「打造出既安全又有益的AGI」。

OpenAI会不会这么做不知道,但Ilya是直接一步做到位了。

消息一出,立刻引得网友们奔走相告。

果然,出走半生,Ilya最心系的还是AI安全。

而官方介绍的第一句话,就十分震撼——「超级智能触手可及」。

个人介绍也第一时间更新为SSI

现在,全网都在翘首以盼,Ilya将拿出震惊全人类的世界级前沿研究。

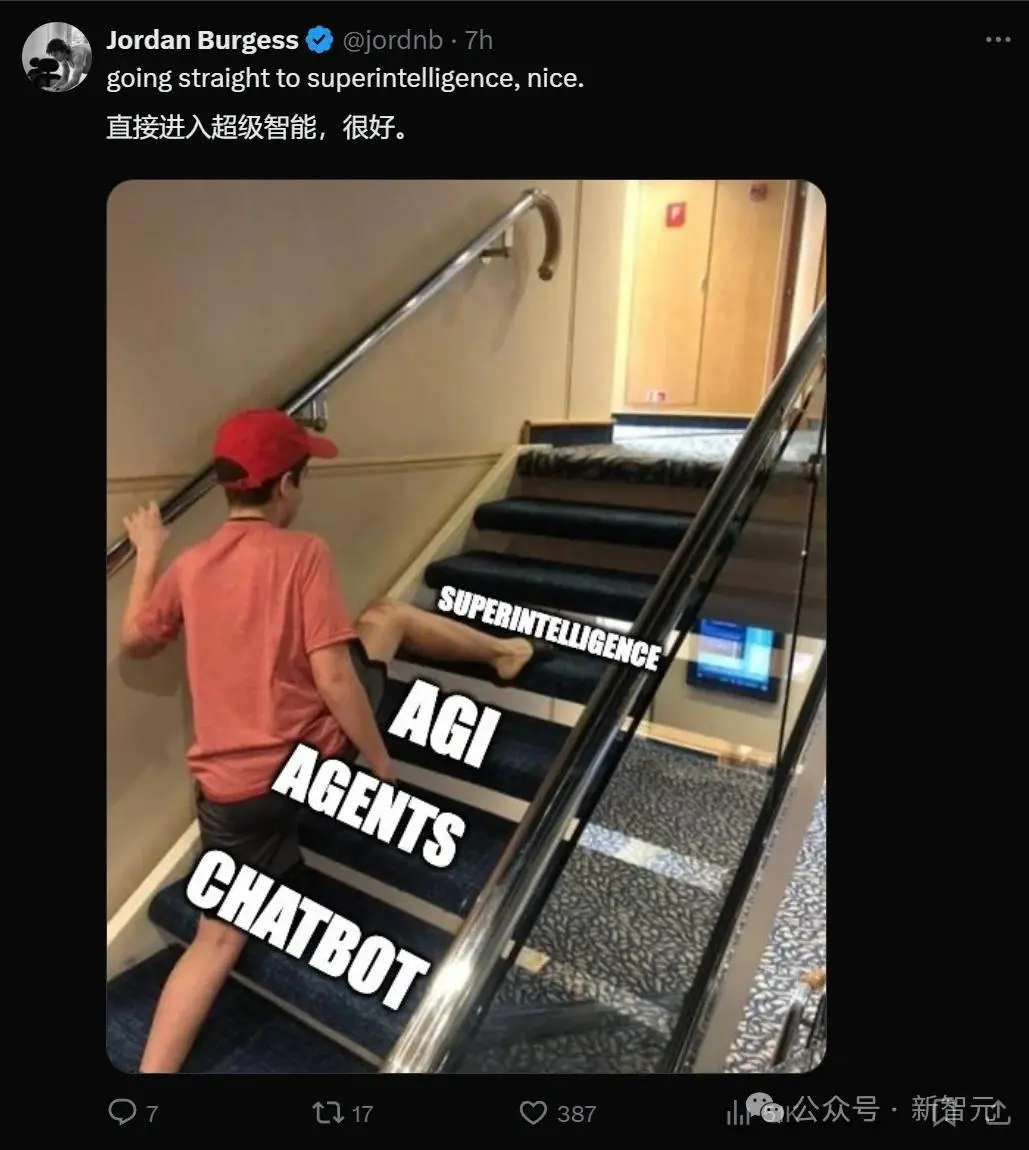

网友:直接一步迈入超级智能

Ilya口中的「SSI」,也即安全超级智能,究竟是指什么意思呢?

显然,这将是Ilya毕生事业之所系,也大概率是他和Sam Altman发生严重的理念不和,从而出走OpenAI的主因。

这下可好,我们直接越过AGI,一步迈进Super Intelligence(超级智能)了。

要是别人说这个话可能是托大,但他可是Ilya。他在OpenAI看到的东西,或许真能把全体人类带向超级智能。

评论区有人拿LeCun玩梗。

有人cue到Ilya的前东家奥特曼。

当然,也有网友发出了灵魂拷问:你们并不是第一家因为安全理念不合,从OpenAI分支出来的公司了。SSI会和Anthropic有什么不同吗?

是的,这一幕仿佛历史的重演,想当年OpenAI创立时,也曾发下类似「造福全人类」的豪言壮语。

这一次,会是历史的轮回吗?

的确,从Ilya发出离别信、po出和OpenAI众元老合影的那天起,一个时代已经终结。

Ilya:我要打造的安全超级智能,是这样的

在SSI的官方介绍语中,Ilya这样解释了公司的宗旨和愿景——目标唯有一个,就是「实现安全的超级智能」。

并且,Ilya同时向天下牛人们广发英雄令,召集世界上最优秀的工程师和研究者来「完成你一生的工作,并帮助解决我们这个时代最重要的技术挑战」。

超级智能即将实现。

构建安全的超级智能(SSI)是我们这个时代最重要的技术问题。

我们已经启动了世界上第一个专注于SSI的实验室,目标只有一个:实现安全的超级智能。

它的名字是Safe Superintelligence Inc(安全超级智能公司)。

SSI是我们的使命、我们的名字和我们整个产品路线图,因为这是我们唯一的重点。我们的团队、投资者和商业模式都一致致力于实现SSI。

我们将安全性和能力视为需要通过革命性工程和科学突破来解决的技术问题,并行推进。我们计划尽可能快地提高能力,同时确保我们的安全性始终领先。

这样,我们就可以安心地扩展规模。

我们单一的目标意味着不会被管理负担或产品周期分散注意力,我们的商业模式意味着安全性、安全性和进步都不会受到短期商业压力的影响。

我们是一家美国公司,在帕洛阿尔托和特拉维夫设有办事处,我们在那里有深厚的根基,并有能力招聘顶尖的技术人才。

我们正在组建一支由世界上最优秀的工程师和研究人员组成的精干团队,专注于SSI及其他任何事情。

如果你是这样的人,我们提供一个机会,让你完成你一生的工作,并帮助解决我们这个时代最重要的技术挑战。

现在是时候了。加入我们。

Ilya Sutskever, Daniel Gross, Daniel Levy

2024年6月19日

SSI联创

而SSI的几位联创,背景分别是这样的。

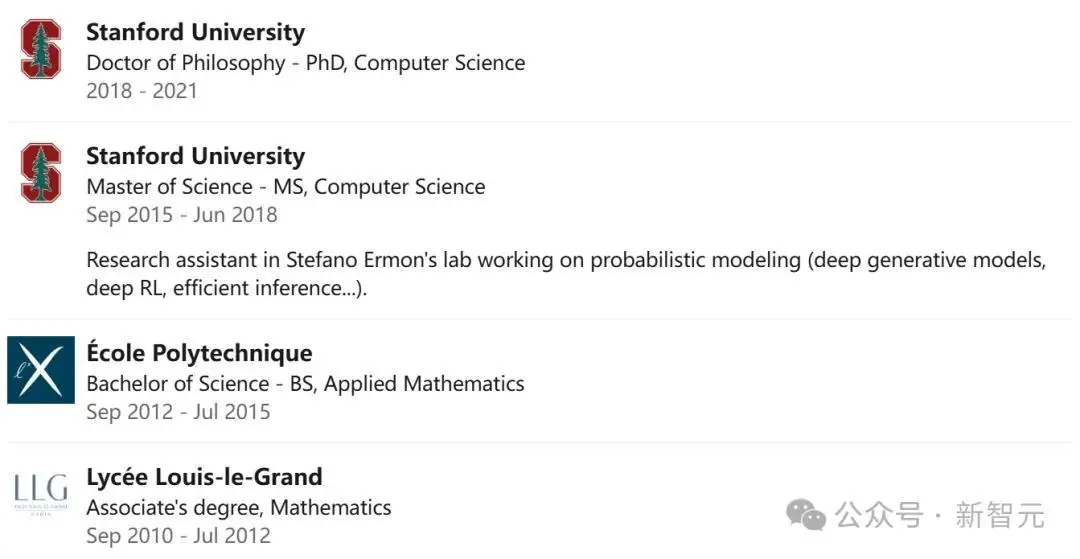

Daniel Leviy

Daniel Leviy曾在2022年加入OpenAI担任技术员工,领导了优化团队(Optimization team)。

此前,他于2021年在斯坦福大学获得计算机科学博士学位,导师是John Duchi,主要研究方向在机器学习、优化和隐私。

并于2018年获得斯坦福计算机科学硕士学位,由Stefano Ermon教授指导,在概率模型和强化学习方面做研究。2015年获得巴黎综合理工学院应用数学学士学位。

入职OpenAI之前,他还在Facebook应用机器学习、谷歌大脑实习。

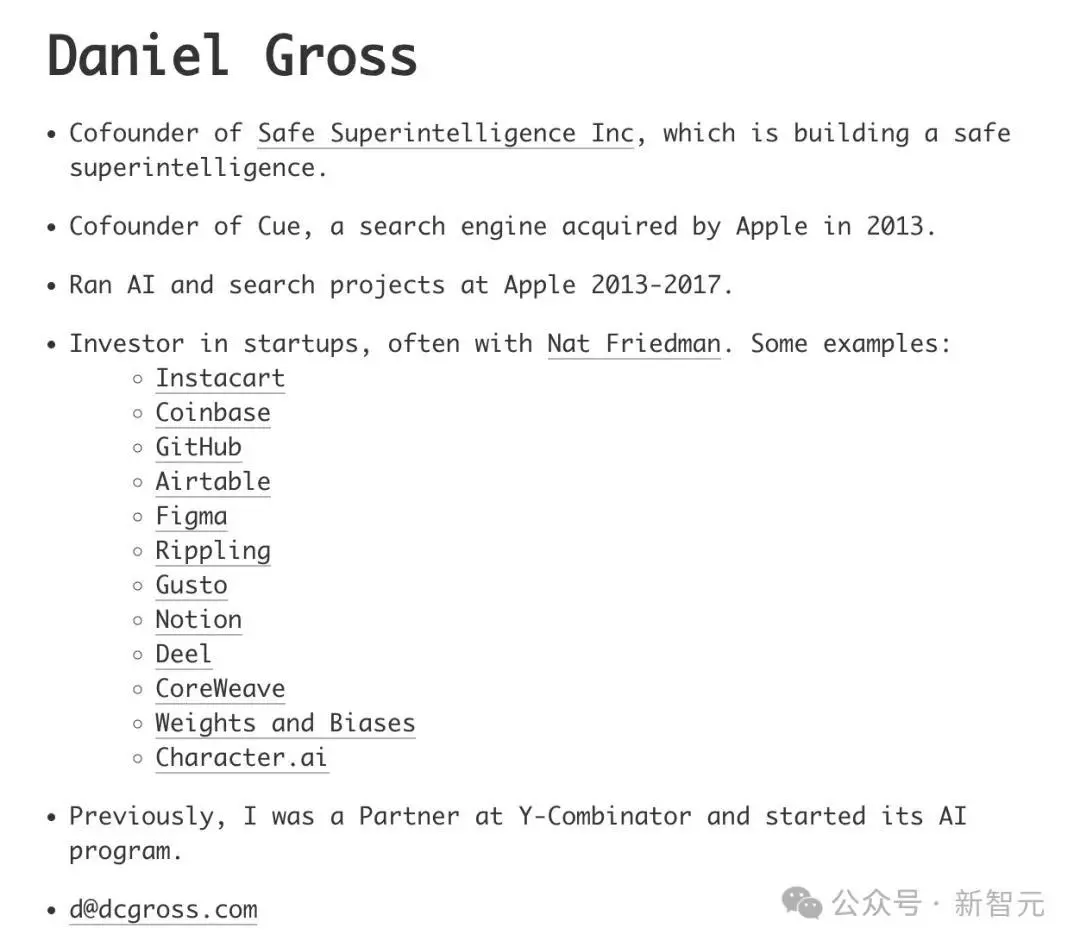

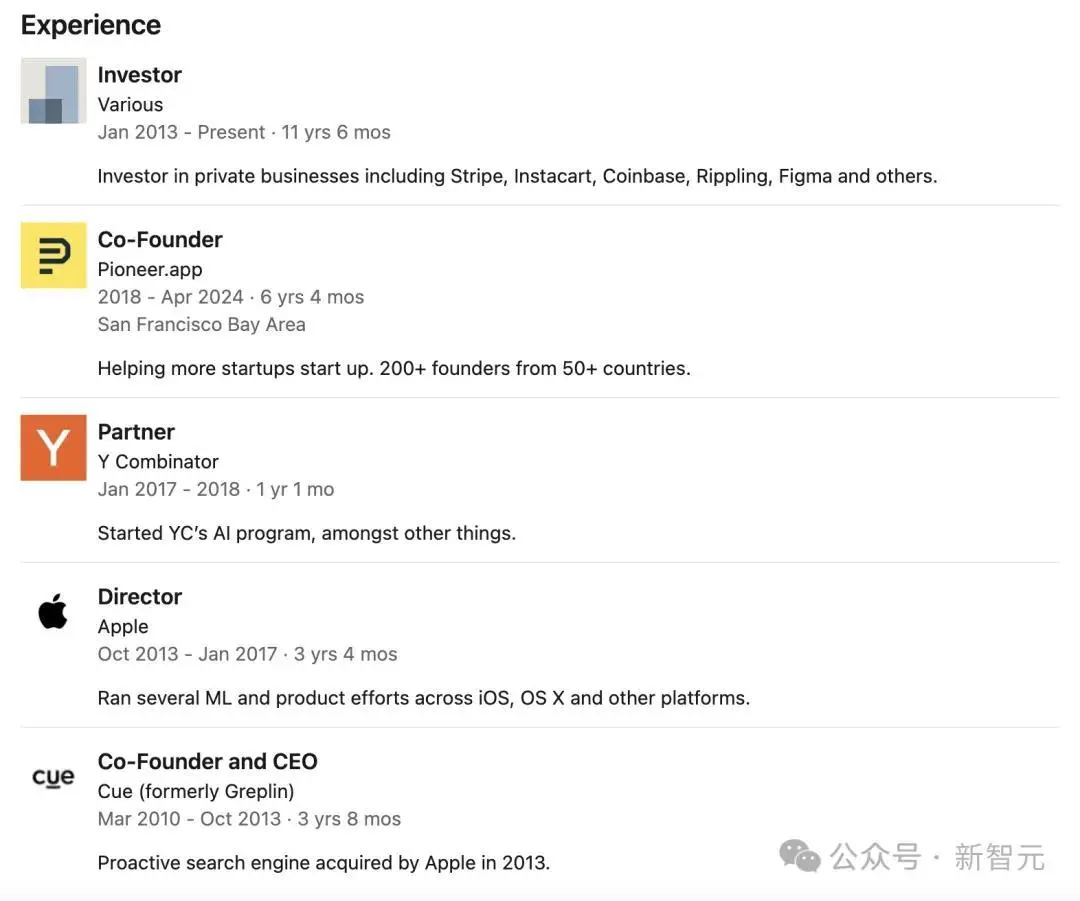

Daniel Gross

Daniel Gross本人的LinkedIn个人主页暂时还未更新。不过,他本人介绍中已经更新了自己是SSI创始人。

在19岁的时候,Gross创办了搜索引擎公司Greplin(随后更名为Cue),2013年被苹果收购后,据称以4000万-6000万完成交易,他便加入了苹果公司。

在此期间,他领导了苹果AI和搜索的项目。

离职苹果之后,Gross作为Y-Combinator合伙人,成立了全新的AI项目部门。也就是从那时起,他一直专注于投资。

2018年,Gross再次创业,创办了Pioneer.app,专为创业者提供启动资金的加速器。

过去几年里,他投资了多家公司,其中就包括我们熟知的——Uber、Character.ai、Perplexity.ai、Figma、GitHub等等。

而且,2021年开始他联手Nat Friedman在AI领域展开重大投资,并运营一个AI Grant的项目,向AI本土公司提供25万美元的资金支持。

去年,他们还部署了超算——Andromeda Cluster,由2,512个H100组成,供投资初创公司使用。

Daniel Gross还被时代期刊「Time 100」评为2023年AI领域最具影响力的人物之一。

Ilya专访:我要的是核安全

正如公司名字所强调的那样,Ilya将AI安全性置于首要地位。

关键当然在于,确认哪种AI系统比其他系统更安全,或者真正意义上的安全性到底是什么。

目前,Ilya对此说法比较含糊。

不过,他本人也暗示了,SSI将试图通过在AI系统中植入「工程突破」来实现安全性,而不是依赖于对AI施加实时的防护措施。

他本人表示,当我们说安全时,我们指的是「核安全」,而非「信任与安全」。

在硅谷,Ilya拥有近乎神话般的地位,始终是全行业关注的焦点。

在不少人眼里,没有Ilya的OpenAI就什么也不是。如果不是Ilya,或许OpenAI不会这么快因ChatGPT而崛起。

这句留言说出了大家的心声——「最终,奥特曼可能仍然会做正确的事情,但你可以永远相信Ilya」。

在接受Bloomberg的独家采访时,Ilya强调,在SSI到达的安全超级智能之前,它不会做任何事。

「它将免受必须处理大型而复杂的产品,以及必须陷入竞争激烈的外部压力的影响。」

不过,Ilya拒绝透露SSI背后的财务支持者是谁,也并未透露目前公司筹集了多少资金。

经历了OpenAI复杂的宫斗事件后,Ilya的再出发,也是某种返璞归真——

安全超级智能,在某种程度上是对最初OpenAI概念的回归:一个研究组织试图构建一种在许多任务上,可以等于甚至超越人类的通用人工智能。

只不过,随着算力导致的资金缺口增大,OpenAI投奔了微软,导致公司的组织结构变了。

所有的AI参与者,都面临着同样的难题:AI模型的规模在指数级增长,需要为不断扩大的计算需求付出代价。

这种经济现实,也使SSI成为投资者的一场豪赌:押注Ilya和团队是否会取得突破,是否更有优势。

但Gross已经保证:「在我们面临的所有问题中,资金绝不是问题。」

Ilya表示,他花了数年事件思考安全问题,而且已经想到了一些方法。

在最基本的层面上,安全的超级智能应该具有不会大规模伤害人类的特性。在此之后,我们可以说我们希望它成为一股向善的力量。我们希望在一些关键价值观的基础上开展运营。我们正在思考的一些价值观,可能是过去几百年来支撑自由民主的成功价值观,比如自由、民主。

在他看来,主导AI的LLM将在SSI中发挥重要作用,但他的目标是更大的东西。比起和我们交谈、对话之后就完事了的LLM,他想要的系统更加通用、功能更广泛。

「你指的是一个正在自主开发技术的巨型超级数据中心。这太疯狂了,对吧?我们希望为安全做出贡献。」

让我们期待,Ilya重新起航后,麾下的新公司会给全人类带来怎样的惊喜。

Prev Chapter:英伟达为何力推“主权AI”

Next Chapter:#Claude最新版本吊打GPT-4o# 就很突然,Claude 3.5,它来了!

评论区

- 这篇文章还没有收到评论,赶紧来抢沙发吧~

【随机内容】

-

融资3500万元,漫画+NFT公司Minto获Piccoma投资

2022-05-15 -

Battle Through the Heavens Chapter 863: A Big Battle Begins

2024-11-19 -

invincible Chapter 690: Are You Certain?

2024-11-18 -

Martial God Asura Chapter 4684: Hidden Dragon Soul Armor

2024-11-09