Meta发布3D Gen AI模型:1分钟内生成高质量3D内容_tiknovel-最新最全的nft,web3,AI技术资讯技术社区

Meta发布3D Gen AI模型:1分钟内生成高质量3D内容

2024-07-03 16:13:36 浏览:399 作者:管理员

Meta发布3D Gen AI模型:1分钟内生成高质量3D内容

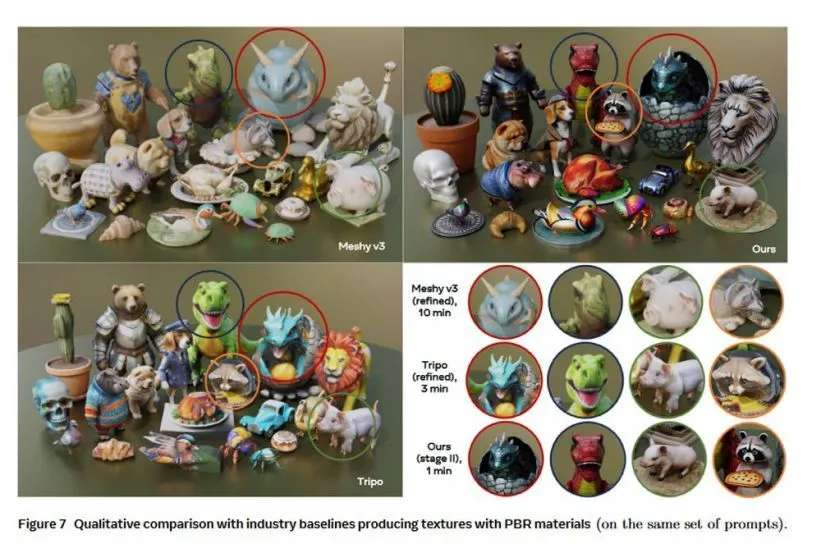

7 月 3 日消息,Meta 公司昨日(7 月 2 日)发布研究论文,介绍了名为 Meta 3D Gen(3DGen)的全新 AI 模型,可以在 1 分钟内基于用户输入的提示词,生成高质量的 3D 内容。

Meta 公司表示 Meta 3D Gen(3DGen)所生成的 3D 内容具备高分辨率纹理和材质贴图,还支持基于物理的渲染(PBR),并能对此前生成的 3D 内容重新再生成新纹理。

IT之家援引论文主要内容,Meta 3D Gen 包含 text-to-3D 生成和 text-to-texture 生成两个主要组件,其工作原理如下:

第一阶段

根据用户提供的文本提示,第一阶段使用 Meta 的三维资产生成模型(AssetGen)创建初始 3D 资产。该步骤生成一个带有纹理和 PBR 材质贴图的 3D mesh。推理时间约为 30 秒。

第二阶段

案例 1:生成更细化的 3D 纹理

根据阶段 1 生成的三维资产和初始文本提示,阶段 2 将为该资产生成更高质量的纹理和 PBR 贴图。它使用 Meta 的文本到纹理生成器 Meta 3D TextureGen。推理时间约为 20 秒。

案例 2:再生成 3D 纹理

给定一个未纹理化的 3D mesh 和一个描述其所需外观的提示。阶段 2 还可以从头开始为该三维资产生成纹理(mesh 可以是以前生成的,也可以是艺术家创建的)。推理时间约为 20 秒。

IT之家附上完整报告链接,感兴趣的用户可以深入阅读。

Prev Chapter:字节、腾讯争夺AI分发权

Next Chapter:大模型与程序员,谁吃了谁

评论区

共 0 条评论

- 这篇文章还没有收到评论,赶紧来抢沙发吧~