12天人工智能马拉松式直播结束,一口气看完OpenAI所有要点_tiknovel-最新最全的nft,web3,AI技术资讯技术社区

12天人工智能马拉松式直播结束,一口气看完OpenAI所有要点

Open AI为期12天的直播,结束了。

科技圈博主和KOL们终于可以松一口气,对于Sam团队而言,这场马拉松式的直播无疑是一次巨大挑战,估计他们累得够呛。

OpenAI为长达12天的活动取名为“Shipmas”。

Shipmas,是「ship」和「Christmas」的组合。简单讲,在特殊时期,推出很多产品更新,既给用户带来惊喜,也像在庆祝节日一样。

刚开始发布时,我还跟朋友说,国内大模型公司在搞发布会,应该跟Open Ai取取经。

冬天那么冷,去现场听演讲,结果讲的内容也不多,大家在台下,有的玩手机,有的只是来打个卡,说实话,花那么多钱,最后只换来几篇报道和几条朋友圈,对客户和宣传效果都很有限。

OpenAI的做法有些不同。

他们只要一个小黑屋、一张桌子、两台电脑和四个人,就能搞定一切。 虽然更新速度有点像挤牙膏,但是这样能让关注他们产品的客户、用户清楚地知道他们在做什么。

有人觉得这种渐进式的发布会缺乏吸引力,但实际上,它在传播信息同时,让关注的人有机会更深入地了解背后的模型和技术理念。

比如说:

关于技术微调的细节。如果在大型发布会上简单提及,可能几句话就带过了,大家的印象也不会很深。

但如果单独用一天时间深入讲解,就能展示更多的例子和演示,让技术人员和用户更直观地理解这些技术细节,从而达到更实际和深刻的认识。

所以,这种办法很适合经济实用型的公司尝试一下。 发布会已经进行到第四天了,我连续熬了三个大夜。如果你错过了前几天的内容,我来帮你补上。

活动第一天,OpenAI推出o1完整版及o1 pro模式。

什么是o1模型完整版呢?

这个版本在之前的o1预览版上做了全面提升。它现在不仅能处理文本,还能处理截图、照片、网页、上传的文件等等,功能更强大了。

而且,它还采用了新的推理方式。就像人的思维方式一样,o1模型完整版会一步步推理,这样在回答专业问题时就更准确了。

跟预览版比,这个版本的o1模型思考问题更简洁,速度提高了50%,而且在回答难题时,出错的可能性也降低了34%。

作为个人博主,这些数据我肯定没办法测试,但我可以跟你讲讲官方给的例子。

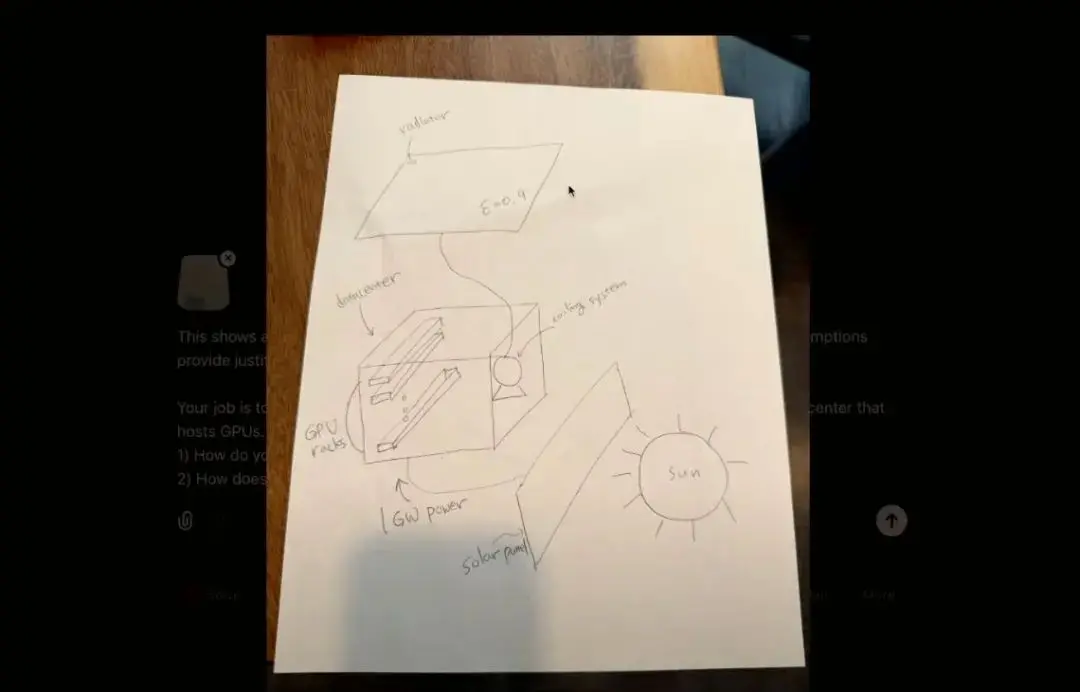

发布会上,o1模型的负责人画了一个草图。这个草图是关于一个系统,用来收集太阳能,供应给太空数据中心。

因为太空里不能用水冷却系统,所以得靠一个巨大的散热片来散热;研究员问o1模型,如果要给数据中心提供1吉瓦的电力,需要多大地方的散热片才能保证GPU正常工作?

o1模型准确地识别了草图,经过分析和计算,得出结论:需要242万平方米的散热片来满足散热需求。

不说别的,至少从演示上看,的确很强大。

不过,强大归强大,之前大家说的那个「有点贵」的版本,第一天就出现了,他们推出的ChatGPT Pro。

这个服务,每个月要200美金,可以随便用他们最先进的模型和工具,包括OpenAI的o1、o1-mini、GPT-4o和Advanced Voice,主要给需要解决特别复杂计算问题的人准备的。

我觉得,这种服务可能更适合那些需要搞高级数据分析、处理的科研人员、工程师还有其他的一些专业人士,能帮他们提高工作效率,也能让他们跟上人工智能的最新技术。

有专家测试说o1 pro模式在处理那些复杂的数据科学、编程和案例分析问题时,确实能给出比以前的模型更准确的答案;在数学、科学和编程这些领域的机器学习测试里,o1 pro模式比o1和o1-preview模型表现更好。

但是,他们会花200美刀用这个吗? 我不知道。 当时, 还开玩笑在朋友圈说,有这么多预算,还不如用集合工具Monica,一个月不到20美金,能用十几个模型,不是更划算吗?

第二天open AI推出了什么呢?

一句话总结即: 推出强化微调能力(Reinforcement Fine-Tuning)。 什么是强化微调?简单的说:给AI模型一个“专业培训课程”。

通过强化微调,可以用很少的实际案例(比如:几十个例子)来教这个AI模型成为一个领域的专家。

直播里,四个人在场,唯一的华裔女研究员Julie Wang介绍了这个能力。她说,这个能力能让小体量的模型“从高中水平跳到专家水平”。

实操环节,他们举了两个例子。

一个是和汤森路透合作的,为法律专业人士打造的AI模型。他们觉得,在很多行业里,虽然专家有很深的专业知识和丰富的经验,但在处理大量数据和复杂任务时,可能会因为时间和精力的限制。

比如:在法律领域,律师要处理好多法律条文和案例。

他们可以用专业知识分析,但如果用经过强化微调的AI模型,可以更快地找到相关案例,进行初步的法律条文匹配,给律师提供决策参考,提高工作效率。

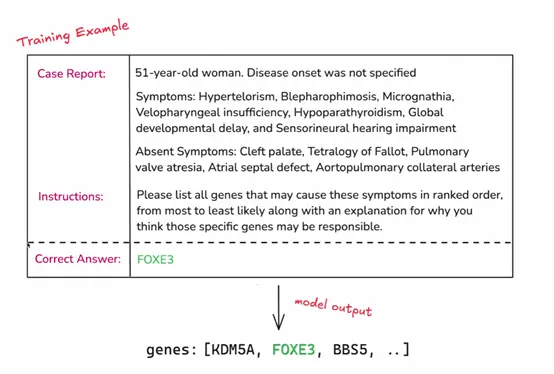

但这个例子是一个展示,似乎没什么说服力。 另一个例子是, 生物医学任务的实验 。

伯克利大学的罕见遗传病研究员Justin Reese,把很多临床病例数据通过API输入到o1 mini模型里。

这些数据包括病人的基本信息、症状描述。比如:一个51岁的女性,症状有眼距过宽、睑裂狭小、软腭咽闭合不全、甲状旁腺功能减退、全身发育迟缓和感觉神经性听力障碍、等等。

然后,用强化微调技术训练o1 mini模型做医疗诊断任务。 训练时,模型要根据症状描述找出可能的基因,并排序。

评分模型会对答案打分,分数从0到1。0表示模型输出中没有正确答案,1表示正确答案在输出的第一个位置,通过性能监控,可以看到微调过程中模型指标的变化。

结果表明,经过强化微调的o1 mini模型在特定任务上的表现超过了更强大的o1模型,在top@1、top@5和top@max这些指标上,o1 mini模型都明显超过了o1模型。

这个案例,在OpenAI的官网可以看到。 不过,两个能力都是「期货」,明年才正式推出,主要面向企业或科研单位等潜在客户。

千万不要小看微调技术,说实话,现在大型语言模型(LLM)还做不到复杂的创造性活动,比如:批判性思维和深度头脑风暴。

这既是坏事也是好事, 因为这样,我们就可以把模型用在那些琐碎、重复、无聊而且不需要创造性的任务上,这样做,它们就能慢慢提高自己的准确性。

这就是,第二天的内容,一个词总结即:微调技术。

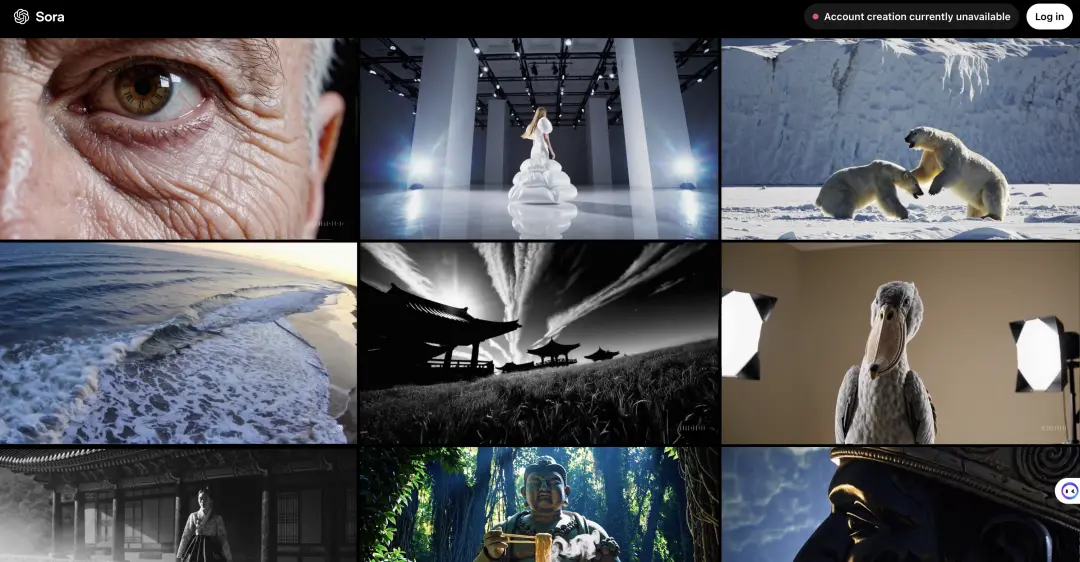

Open AI第三天推出了sora。 鸽子一年多的期货来了,不过,因为之前连续熬夜,我实在撑不住,12点半就睡了。第二天醒来想试试Sora,但登录时发现因为用户太多,暂时用不了。

没关系,我看了Sora的发布会。

OpenAI团队在会上展示了这个工具的厉害之处,还教大家怎么用;他们教我们怎么生成视频,包括设置分镜、输入视频指令、选风格、画面比例、时长等等。通过演示,让所有人对Sora有了更深的认识。

Sora的使用过程相当灵活,你可以用分镜功能看不同角度的画面,然后,输入你想要视频怎么做。OpenAI说:指令越简单,Sora自己发挥的越多;指令越详细,它就越听你的。

在直播中,Sora把两个不连着的视频片段合成了一段有故事感的视频。虽然细节有点出入,但整体效果的确令人惊讶。

Sora还能让你上传图片或视频,然后生成后续视频的文字描述。你可以随便改指令,在时间轴上调整,决定视频啥时候播。这个功能挺有创造力的。

还有一点,生成视频后,还能用remix工具改。

这个工具看起来很丝滑,它能对视频进行各种创意上的改编。怎么改呢?可以调强度,从1级到8级,想要多大变化都行。

还有预设的选项,比如:温和、适中或者强烈。用这个工具,可以保留视频里想要的部分,其他的,想怎么变就怎么变,比如:把猛犸象换成机器人,或者变人物表情等等。

我觉得,Sora不光是视频工具,它把视频生成和工作流程结合起来了,这对OpenAI挺重要;因为Sam Altman在直播里说,他们想让AI理解视频,改变我们用电脑的方式。

想要做到这点,在通往AGI的路上,得做很多优化,而把工作流和视频生成结合起来,是个不错的办法。

不过,Sora看着不错,但是价格有点高。比如:

你要是选Plus会员,每个月得花20美元,能做最多50个视频,视频质量一般,最高只能到720p,而且每个视频最长也就5秒。

如果你想要更好的,得选Pro会员,一个月得200美元,最高清晰度能到1080p,每个视频才能生成20秒,而且Sora尚未在欧盟、瑞士和英国上线。

这就是第三天关于Sora的内容,感叹又期待,你会付费吗?

今天,OpenAI直播到了第四天,由他们的首席产品官Kevin Weil来主持。重点是什么呢?即:Canvas正式上线了。

之前,Canvas的一些功能已经在ChatGPT里展示过,但那时它是单独的一个模型。现在,它和其他模型融合在一起了。

那么,Canvas这次和以前有什么不同呢?有三个:

一,现在可以直接 从首页的输入框跳转到Canvas ; 二,集成了一个Web Assembly的Python模拟器, 可以直接运行Python代码,还能在线修bug ; 三,Canvas功能 整合进了GPTs。

为了让大家更清楚地看到Canvas的新功能,OpenAI的工程师Lee和Alexey还做了现场演示。Lee教我们怎么用Canvas写一个儿童圣诞故事。

在ChatGPT的输入框里,点一下新加的工具按钮,就能切换到Canvas,你可以和ChatGPT一起编辑文档,不管是改标题、加表情,还是调整文章的长度和阅读难度,都变得很简单。

这就像百度的自由画布,用户和ChatGPT可以一起创作,写作和修改的过程都很自然。

发布会上,Alexey还展示了Canvas怎么帮我们改文章。 他把一篇关于“圣诞老人、暗能量和驯鹿推进力”的物理论文贴到ChatGPT里,然后用Canvas打开。

ChatGPT不仅能给出专业的修改建议,还能在文章里直接加评论,这样用户就能很方便地查看和修改。用户可以根据自己的思路来改文章,想复制最终版本也随时可以。

Alexey还演示了怎么用Canvas调试Python代码和生成图表。 Canvas里内置了一个WebAssembly Python模拟器,可以快速加载几乎所有Python库,运行代码,还能即时反馈,这对提高编程效率真的很有帮助。

另外,Canvas的功能也整合进了GPTs里。比如:

Lee就创建了一个叫“圣诞老人助手”的GPT,用来帮圣诞老人回复孩子们的信件。

只要在自定义GPT的说明里加上“使用Canvas工具”的指令,再勾选Canvas功能,自定义GPT就能自动在Canvas里生成信件草稿,圣诞老人可以根据实际情况修改草稿,用自己的风格和语气回复孩子们。

我之前一直在用Canvas,还想过,国内厂商啥时候也能引进Canvas这样的功能。 我觉得Canvas(画布)是让大家一起工作更聪明的一个关键步骤。

因为不管是自己用,还是大家一起用,总得有个地方能三个人一起做事情,以前可能用类似于在线文档的工具,实现共同编辑的动作,以后,画布可能是首选协同之一了。

这就是今天发布会的内容,关于Canvas。

好了,总结下四天的内容,分别是:推出o1完整版及o1 pro、推出强化微调能力、推出新产品sora、以及把Canvas进行全新升级。

第五天:

Sam说:嗨,欢来到我们「12 Days of OpenAI」系列的第五天。 今天,我想介绍让 ChatGPT 更加简单易用的一些新功能。

苹果的朋友们正努力将 ChatGPT 集成到 iPhone、iPad 的 iOS 系统以及 macOS 系统中;我们的目标是让 ChatGPT 在各种平台上都能轻松顺畅地使用。

我们都很喜欢 Apple 的设备,因此对这次集成非常自豪, 所以,你可以在不登录的情况下使用ChatGPT了,但如果你有账户,体验会更好。

接下来,正式开始了。工程团队的 Dave和它的伙伴,利用半个小时时间,演示完一切功能。

简单讲,主要有五个核心内容: 一,苹果公司将ChatGPT集成到了iPhone、iPad的iOS系统以及macOS系统中 ,使得用户可以在这些设备上更简单易用地使用ChatGPT。

二,当Siri认为ChatGPT能更好地解决问题时,可以直接将请求交给ChatGPT。三,Apple Intelligence的写作工具现在可以借助ChatGPT从零开始为用户起草文档。

四,在iPhone 16上,用户可以通过摄像头控制功能调动视觉智能,使用ChatGPT来了解镜头里看到的东西。

五,Siri可以直接针对预览状态的文档调用ChatGPT的能力进行问答,用户可以选择是否仅共享当前屏幕截图或共享文档全部内容。

这就是第五天的内容,用一句话总结即: 苹果公司宣布将ChatGPT集成到iOS和macOS系统中,用户可通过Siri直接访问ChatGPT,甚至无需账户即可使用。

第六天,说了什么呢?

首先,发布了两个新功能: 高级视频对话和屏幕共享。 用户现在可以和ChatGPT实时共享屏幕了。

其次,ChatGPT里新增了一个圣诞老人语音模式。只要用户开启语音模式,然后说「hohoho」,就能启动这个模式。

在案例展示环节,团队给ChatGPT展示了水壶和滴漏器的实时视频,在ChatGPT的指导下,他们一步步完成了咖啡制作;ChatGPT给出了几个步骤提示,比如:

在滴漏器中放滤纸、把咖啡粉加到滤器里、慢慢倒热水,要转圈倒”等等。

团队还宣布,这些新功能将支持最新的移动应用、桌面应用、Web平台,还有Teams集成。他们计划在明年年初,把这些功能开放给企业用户和教育用户。

所以, 第六天重点是ChatGPT推出的高级视频对话和屏幕共享功能,还有新增的圣诞老人语音模式,这些更新主要展示了ChatGPT的多模态交互能力。

不知道第七天的内容算不算大招: 推出了Projects。

什么是Projects?

简单来说, 一个能把ChatGPT的所有功能整合到一起的工具,或者你也可以只用Projects,不用ChatGPT的其他功能。

这场发布会是由OpenAI的首席产品官Kevin Weil和他的两个同事Drew Schuster和Thomas Dimson一起主持的。Kevin Weil在直播里说,现在可以把熟悉的ChatGPT功能都整合到项目里,或者,只单独使用项目功能。

Thomas Dimson补充说,Projects像一个智能文件夹,这个功能是基于ChatGPT最近推出的对话搜索功能开发,可以查看和搜索以前的聊天内容,都是文本形式的。

用Projects的方法挺简单,大概分三步:

一.在ChatGPT界面上点「创建项目」按钮;二.把聊天记录加到项目里;三.试试搜索功能。还有个Canvas自由画布工具可以用,不过这些步骤不是一定要全做,每一步都有很多可以发挥的地方。

Projects能用来干啥?

Kevin Weil和他的团队在直播里展示了几个案例。

他们用Projects创建了一个Secret Santa项目,Schuster上传了群组的聊天记录和大家的需求,然后让ChatGPT随机分配任务,还让ChatGPT帮忙写了封邮件给群组。

还有个例子,Schuster上传了一些关于家用电器的笔记,然后问ChatGPT:“冰箱的滤水器什么时候需要更换?”如果你平时有记录家里的重要信息,这个功能就特别有用。

总的来说,Projects有三大功能:

一,帮我管理项目,把聊天记录、文件这些都放在一起,方便整理;二,有搜索功能,即使项目里堆了很多东西,也能快速找到需要的内容。

三,融合Canvas自由画布工具,这个功能能让我更直观地看到项目里的内容,整理起来更清晰。这个功能是免费的,我觉得有点像在模仿Claude。

这就是第七天的内容,一句话总结即推出Projects。

第八天,OpenAI给我们带来了几个新消息;首先,他们宣布ChatGPT Search现在对所有登录的免费用户开放了,不管是用网页版,还是iOS、Android手机都能用。

产品负责人Kevin Wheel说,这个搜索功能特别重要;用它能帮ChatGPT找到最新的信息,回答网上的问题。他自己也每天都在用,很高兴现在大家都能用上。

第二,ChatGPT Search还能和高级语音模式一起用。这样,用语音和ChatGPT聊天的时候,也能顺便搜索信息,让语音交流更厉害、更方便。

还有,ChatGPT Search现在和Apple Maps合作了。

如果你在iOS的ChatGPT应用里找到一家餐厅,可以直接点一下,用Apple Maps导航过去。这说明ChatGPT Search和Apple Maps合作得很紧密。

另外,在手机应用里,你可以用语音模式和ChatGPT聊天。它会把你的语音问题和网上的信息结合起来,给你答案。比如,你问圣诞市场的事,它就会告诉你什么时候开门,哪天营业。

最后,ChatGPT Search还能加到浏览器里,你可以把它设成默认的搜索引擎,这样上网搜东西就更快,还能得到智能的搜索建议。

总之,第八天的内容重点是ChatGPT Search功能的扩展和增强。 包括了全球用户都能用、和Apple Maps的合作、手机应用里的语音模式,还有浏览器的集成,这些更新让ChatGPT的搜索能力变得更强了。

第九天的活动被称为 「对开发者最有用的一天」 。

这一天,他们推出了o1模型的正式版API;这个新版本的o1模型速度更快,成本更低,还增加了视觉识别和函数调用等新功能。这让开发者在构建应用时更加轻松。

现场演示中,Michelle Pogras和Brian John展示了o1模型的新特性。 他们介绍了函数调用、结构化输出、开发者消息、推理参数和视觉输入等功能。

他们特别演示了如何使用o1模型的视觉输入功能解析税务表单,展示了模型如何识别表单中的错误,并输出修正后的结果。

接下来,实时API也进行了全面升级。 OpenAI引入了WebRTC支持,这大大简化了实时语音应用的开发流程。同时,相关服务的价格也大幅降低,其中GPT-4o的音频处理费用降低了60%。

Olivier Godement介绍了WebRTC集成的新功能,展示了怎么自动处理音频流、管理网络拥堵、实时噪声抑制和音频编码,还支持了原生浏览器API。

最后,他们推出了「偏好微调」功能 ;这个技术让开发者可以根据用户的偏好,定制AI模型的回答风格和内容。比如,金融科技公司用了这个功能后,AI助手的准确率提高了5个百分点以上。

Michelle Pogras提到,这项技术有成对比较学习机制、人类标注和A/B测试支持,还能生成合成数据。他们展示了这项技术在金融分析助手中的应用案例,说明了怎么通过优化提升查询的准确率。

所以,这一天的重点有三个: o1模型API的正式推出、实时API的升级和价格调整、以及偏好微调功能的推出。

第十天有什么呢?

OpenAI在第10天的活动里,搞了两个新动作:

一,他们开了ChatGPT的热线电话服务。 就像给朋友打电话一样,你可以直接拨1-800-CHAT-GPT(也就是1-800-242-8478)和ChatGPT聊天;这个服务每个月送你15分钟免费通话,对那些想快点问个问题或者试试新功能的人来说,挺方便的。

二,他们让ChatGPT能集成到WhatsApp里。 这样,你就能在WhatsApp上直接和ChatGPT聊天,不用换应用,也不用开电脑,聊天变得更简单。

不过,这个功能有两个限制:

目前只对美国用户开放,因为号码是美国的;第二,每个月免费通话时间只有15分钟,如果你聊得更多,可能得想别的办法。

还有,聊天的时候不支持上网搜信息,只能根据它学过的东西回答。所以,如果你已经有ChatGPT Plus,可能还是用ChatGPT App里的高级语音模式更合适。今天这个功能,主要是给你多一个选择。

我觉得,第十天的活动,没那么激动人心。 说白了,就是你可以打电话给ChatGPT了。其实,国内的豆包、文小言、Kimi,早就能做到。

第十一天的内容,关于「桌面应用程序」。

产品负责人Kevin Wheel和团队成员John Nastos、Justin Rushing介绍了一些新的桌面应用程序功能。这些功能是为了帮助大家在Mac和Windows电脑上工作得更快、更好。

那么,桌面应用程序都有哪些好处呢?

让ChatGPT变得更能干,不只是回答问题,还能自动帮你完成任务;这个应用程序能看你的屏幕,帮你自动化工作流程,让你工作更高效。

Justin展示了怎么用ChatGPT和Warp终端一起玩。

比如:数数Git仓库里提交了多少次代码,还能生成图表。John则演示了在Xcode里怎么用ChatGPT帮忙编程,实时写出代码,还能调试。

ChatGPT现在还能和Apple Notes、Notion、Quip这些应用互动,你可以直接在这些应用里写东西、编辑;新加的高级语音模式让你能通过说话和ChatGPT交流,立刻得到回应,让用起来更爽。

所有新功能在直播结束后就推出了,你只需要更新到最新版的ChatGPT Mac应用程序就能用;通过新功能,OpenAI希望大家能更好地掌握和自动化自己的工作流程,提高工作效率。

简单来说,三点:

一是「增强的自动化能力」,桌面应用程序能看你的屏幕,自动化你的工作流程,提高工作效率。

二是「跨应用协作」 ,ChatGPT可以和Warp终端、Xcode、Apple Notes、Notion、Quip等多种应用互动,不管你是编程、记笔记还是项目管理,都能实时帮忙。

三是「语音交互功能」 ,新加的高级语音模式让你能通过说话和ChatGPT交流,实现更自然、更便捷的交互体验,进一步提高你的工作和操作效率。

今天是最后一天,也是直播的第十二天, OpenAI重点介绍了o3和o3 mini的预告。为啥跳过了o2?为了避免版权问题,OpenAI直接用了o3这个名字。

如果要我用一句话形容o3,我会说——它强大得让人震惊,可能会给程序员带来冲击。

为什么这么说呢?

我们先来看看OpenAI的研究员怎么说。o1是第一个大型推理模型,它只是用强化学习(RL)训练的大型语言模型(LLM)。o3则是在o1的基础上,进一步扩展了RL的应用,结果非常令人印象深刻。

简单来说,o1只是证明了LLM加上RL是可行的,但我们并没有全力以赴;o3则是全力以赴,通过扩大规模,真正释放了LLM加RL的潜力。

这也验证了一点——对于编程、数学这类能够明确定义任务奖励和容易获取过程数据的任务,通过强化学习,它们的潜力可以不断被挖掘,直到达到世界顶级水平。

那么,o3有哪些核心能力呢?官方展示了一些数据。

首先,o3模型在Codeforces编程比赛中获得了2727分,这个分数让它达到了国际特级大师的水平, 大约在全球竞争性人类编码者中排名前200 。这个分数比o1模型的1891分高出了44%。

注释:( Codeforces是一个在线编程比赛平台,让全球的程序员在限定时间内解决算法问题,以此测试和提升自己的编程技能 )。

其次,在2024年美国数学邀请赛(AIME)中,o3模型的得分为96.7%,只错了一道题。 这个得分大幅超过了o1模型的83.3%,相当于一名顶级数学家的水平。 从竞赛数学的角度来看,o3的准确率比o1正式版高15%,比o1预览版高近71%。

这些结果展示了o3模型在编程和数学领域的卓越性能,标志着AI在这些领域的进步。

简单来说,o3的三个亮点:

一是推理能力的大幅提升;二是在数学和逻辑测试中的卓越表现;三是编程能力的突破。

所以,o3在实践上证明了,对于编程这类能够明确定义任务奖励,和容易获取过程数据的任务, 通过对强化学习的扩展,它的潜力可以不断被挖掘,直到成为世界上最顶级的程序员之一。

最让人兴奋的消息是,o3 mini预计明年一月底就会发布!只需要再等一个月!o3 mini上线后,很快就会开放API调用,并附带o1的所有API功能。

好了,以上就是Open AI 12天发布活动的全部内容。你认为哪天的发布能载入AGI史册呢?

Prev Chapter:美媒总结苹果的2024:进军AI、头显,在华表现失望

Next Chapter:OpenAI重磅发布o3!再次突破AI极限,北大校友参与研发

评论区

- 这篇文章还没有收到评论,赶紧来抢沙发吧~