突发:马斯克Grok开源_tiknovel-最新最全的nft,web3,AI技术资讯技术社区

突发:马斯克Grok开源

6个月掏出3410亿参数自研大模型,马斯克说到做到!

智东西3月18日消息,就在刚刚,马斯克的AI创企xAI正式发布了此前备受期待大模型Grok-1,其参数量达到了3140亿,远超OpenAI GPT-3.5的1750亿。

这是迄今参数量最大的开源大语言模型,遵照Apache 2.0协议开放模型权重和架构。

Grok-1是一个混合专家(Mixture-of-Experts,MOE)大模型,这种MOE架构重点在于提高大模型的训练和推理效率,形象地理解,MOE就像把各个领域的“专家”集合到了一起,遇到任务派发给不同领域的专家,最后汇总结论,提升效率。决定每个专家做什么的是被称为“门控网络”的机制。

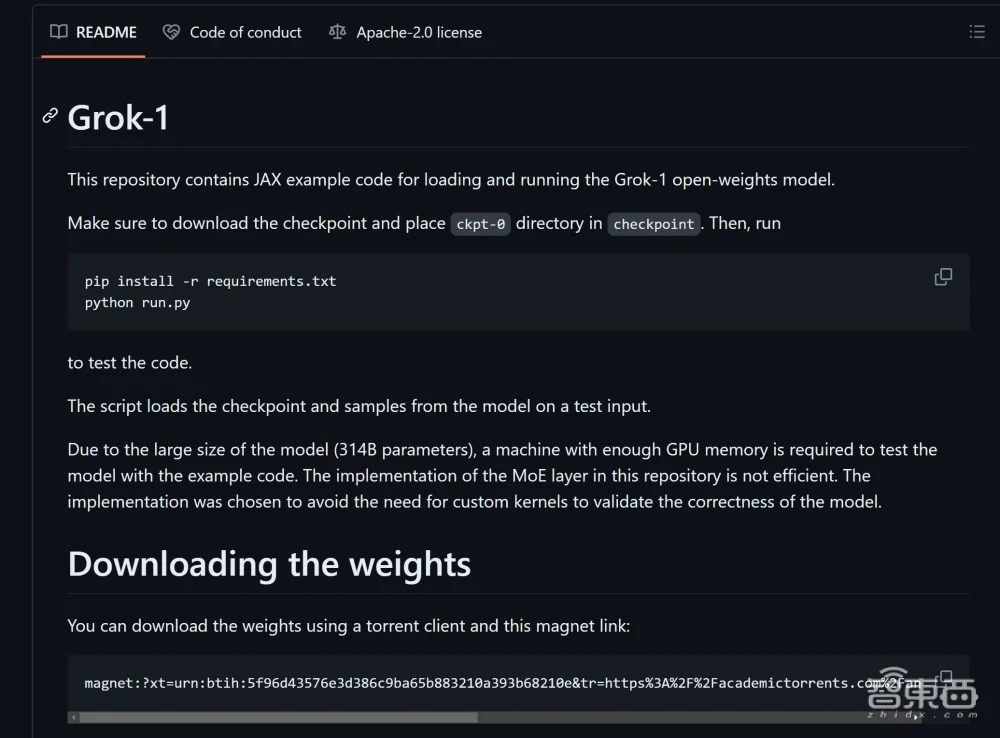

xAI已经将Grok-1的权重和架构在GitHub上开源。

目前Grok-1的源权重数据大小大约为300GB。

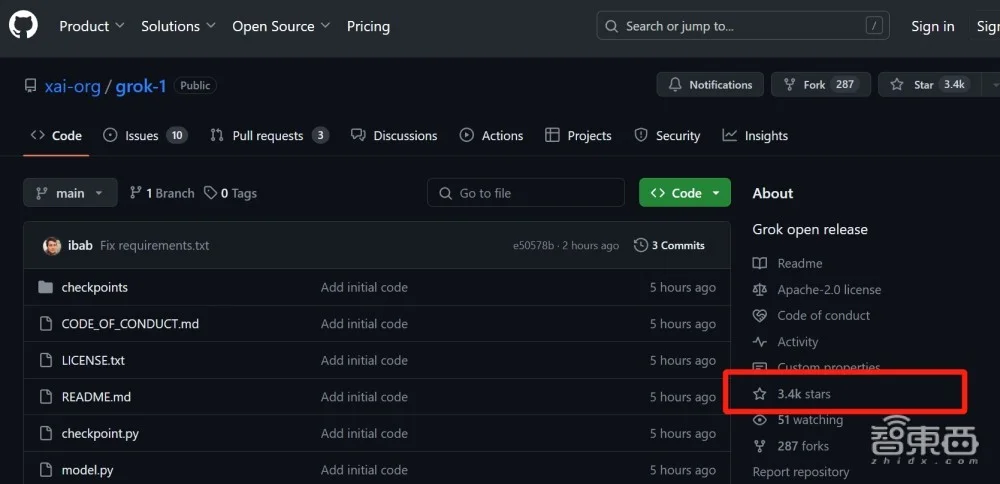

截至北京时间3月18日上午7时许,Grok-1项目收获了3400颗星。

Grok-1是马斯克xAI自2023年7月12日成立以来发布的首个自研大模型。xAI特别强调说这是他们自己从头训练的大模型。Grok-1没有针对特定应用进行微调。

xAI是马斯克去年刚刚成立的明星AI创企,其目的之一就是与OpenAI、谷歌、微软等对手在大模型领域进行竞争,其团队来自OpenAI、谷歌DeepMind、谷歌研究院、微软研究院等诸多知名企业和研究机构。

此前马斯克刚刚“怒喷”OpenAI不够“Open”,后脚这就开源了自家的顶级3410亿参数自研大模型Grok-1。虽然马斯克在预热到发布的过程中也“放了几次鸽子”,但最终他并没有食言。

今天,xAI还公布了Grok-1的更多细节:

基础模型基于大量文本数据训练,未针对特定任务进行微调。

3140亿参数的Mixture-of-Experts模型,其对于每个token,活跃权重比例为25%。

xAI从2023年10月开始使用自定义训练堆栈在JAX和Rust之上从头开始训练。

但此次xAI并没有放出Grok-1的具体测试成绩,其与OpenAI即将发布的GPT-5的大模型王者之战,必将成为业内关注的焦点。

当然,马斯克发大模型,怎么会少的了大佬隔空对线“互怼”?

xAI官方消息刚刚发布,ChatGPT的官方账号马上就跟马斯克在X平台上进行了互动,在Grok官方账号评论下回复道:“偷了我的笑话。”

马斯克自然不会示弱,马上说请告诉我OpenAI“Open”之处在哪里。

马斯克高仿号也马上跑过来添油加醋,说我们都知道是Sam在运营ChatGPT的账号。

值得一提的是,此次xAI发布Grok-1消息的封面图片,是由Midjourney生成,Grok给出了提示文本:一个神经网络的3D插图,具有透明节点和发光连接,展示不同粗细和颜色的连接线的不同权重(A 3D illustration of a neural network, with transparent nodes and glowing connections, showcasing the varying weights as different thicknesses and colors of the connecting lines)。

Prev Chapter:微软AI程序员登场,10倍AI工程师真来了?996自主生成代码性能超GPT-4 30%

Next Chapter:OpenAI首席技术官:不确定是否使用了社交媒体数据训练Sora

评论区

- 这篇文章还没有收到评论,赶紧来抢沙发吧~

【随机内容】

-

Martial Peak Chapter 5980 - Chapter 5980, It’s You

2024-11-15 -

ChatGPT幕后大佬、o1推理模型作者官宣离职!OpenAI大洗牌,后训练团队换将

2024-10-11 -

OpenAI宣布DALL-E 3模型向ChatGPT免费用户开放,但每天只能生成两张图片

2024-08-09 -

Chaotic Sword God Chapter 1351: Shocking Sword Qi

2024-11-13