OpenAI 推出了面向企业的 ChatGPT API_tiknovel-最新最全的nft,web3,AI技术资讯技术社区

OpenAI 推出了面向企业的 ChatGPT API

位于旧金山的初创公司OpenAI开发的免费文本生成人工智能ChatGPT的重要性不必再多言,它的功能大家有目共睹。

截至去年12月,ChatGPT的月活跃用户估计超过1亿人。它吸引了主流媒体的关注,并在社交媒体上催生了无数的meme。它已被用于编写亚马逊Kindle商店的数百本电子书。它还被认为是至少一篇科学论文的共同作者。

但是,OpenAI作为一个企业(尽管是一个有盈利上限的企业)必须以某种方式将ChatGPT变现,以免投资者感到焦躁。它在今年2月份推出了高级服务——ChatGPT Plus,朝着这个方向迈出了一步。今天,它采取了更大的行动,推出了一个API,允许任何企业在其应用程序、网站、产品和服务中使用ChatGPT技术。

API是其一直以来的计划。这是OpenAI总裁兼主席Greg Brockman(也是联合创始人之一)所说的。他昨天下午在ChatGPT API发布之前通过视频电话与媒体进行了交谈。

Brockman说:“我们需要一段时间来使这些API达到一定的质量水平。我认为这是一种能够满足市场需求和规模的方式。”

Brockman说,ChatGPT API由OpenAI大受欢迎的ChatGPT背后的相同AI模型驱动,被称为 “gpt-3.5-turbo”。GPT-3.5是OpenAI目前通过其API套件提供的最强大的文本生成模型;“turbo”这个名称是指OpenAI一直在为ChatGPT悄悄测试的GPT-3.5的优化、更灵敏的版本。

价格为每1000个tokens 0.002美元(或大约750个单词),Brockman声称,该API可以驱动一系列的体验,包括 “非聊天”应用。Snap、Quizlet、Instacart和Shopify是早期采用者之一。

开发gpt-3.5-turbo背后的最初动机可能是为了减少ChatGPT的巨大计算成本。OpenAI首席执行官Sam Altman曾称ChatGPT的支出 “令人瞠目结舌”,他估计每个聊天的计算成本都有几分钱。(只要超过一百万的用户,计算成本就会迅速增加)。

但Brockman说,gpt-3.5-turbo在其他方面也有改进。

Brockman说:“如果你正在建立一个人工智能驱动的导师,你永远不希望导师只是给学生一个答案。你希望它总是解释并帮助他们学习——这就是你应该能够用API建立的那种系统的一个例子。我们认为这将是一个新东西,就像,使API更可用,更容易获得。”

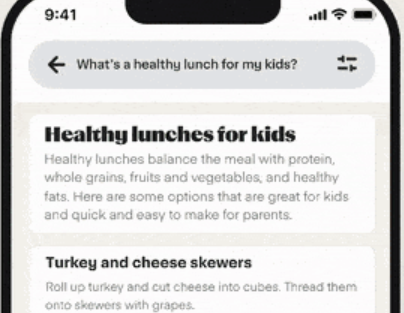

ChatGPT API是My AI的基础,它是Snap最近宣布的针对Snapchat+用户的聊天机器人,以及Quizlet的新Q-Chat虚拟导师功能。Shopify使用ChatGPT API建立了一个个性化的购物推荐助手,而Instacart则利用它创建了Ask Instacart,这是一个即将到来的收费项目,允许Instacart的客户询问食物,并从该公司的零售合作伙伴的产品数据中获得 “可购物的”答案。

Instacart首席架构师JJ Zhuang通过电子邮件告诉媒体:“购买食品可能需要很大的精神负担,这有很多因素在起作用,比如预算、健康和营养、个人口味、季节性、烹饪技巧、准备时间和食谱灵感。如果人工智能可以承担这种心理负担,我们可以帮助那些通常负责杂货店购物、膳食计划和把食物放在桌子上的家庭领导人——实际上让杂货店购物真正变得有趣,那会怎么样?Instacart的人工智能系统与OpenAI的ChatGPT整合后,将使我们能够做到这一点,我们很高兴开始尝试在Instacart应用中的可能性。”

不过,那些一直密切关注ChatGPT传奇的人可能会想知道它是否已经成熟到可以发布了,这么想确实也是正确的。

早期,用户能够促使ChatGPT以种族主义和性别歧视的方式回答问题,这反映了ChatGPT最初训练的数据有偏见。(ChatGPT的训练数据包括广泛的互联网内容,即电子书、Reddit帖子和维基百科文章)。ChatGPT还“发明”了一些事实,但它没有透露正在这样做,这种现象在人工智能中被称为“幻觉”。

ChatGPT(以及类似的系统)也很容易受到基于提示的攻击,或者恶意的对手提示,让他们执行并不属于其原始目标的任务。Reddit上的整个社区已经围绕着寻找 “越狱”ChatGPT和绕过OpenAI设置的任何保障措施的方法而形成。在一个不太令人反感的例子中,初创公司Scale AI的一名员工能够让ChatGPT泄露其内部技术运作的信息。

毫无疑问,品牌商不会想被抓取重要信息数据。Brockman坚称他们不会这样。为什么这么说?他说,原因之一是后端持续改进,在某些情况下是以肯尼亚合同工为代价的。但Brockman强调了一种新的(而且明显不那么有争议的)方法,OpenAI称之为聊天标记语言,或ChatML。ChatML将文本作为一连串的信息和元数据提供给ChatGPT API。这与标准的ChatGPT相反,后者消费的是以一系列标记表示的原始文本。 例如,单词 “fantastic”将被分割成标记“fan”、“tas”和“tic”)。

例如,给定提示 "我30岁生日了,请给一些有趣的聚会想法”开发人员可以选择在该提示后附加一个额外的提示,如 “你是一个有趣的对话式聊天机器人,旨在帮助用户解决他们提出的问题。你应该以有趣的方式如实回答!”或 “你是一个机器人”,然后让ChatGPT API进行处理。Brockman说,这些指示有助于更好地定制(和过滤)ChatGPT模型的反应。

Brockman说:“我们正在向更高层次的API发展。如果你有一个更结构化的方式来表示对系统的输入,你说,'这是来自开发者'或'这是来自用户'......我应该期望,作为一个开发者,你实际上可以更稳健地使用ChatML对抗这些类型的提示攻击”。

另一个变化是更频繁的模型更新,这将(希望)防止意外的ChatGPT行为。随着gpt-3.5-turbo的发布,开发者将默认自动升级到OpenAI的最新稳定模型,Brockman说,从gpt-3.5-turbo-0301(今天发布)开始。不过,如果开发者选择的话,他们可以选择继续使用旧的模型,这可能在某种程度上否定了这种好处。

无论他们是否选择更新到最新的模型,Brockman指出,一些客户(主要是拥有相应大额预算的大型企业)将通过引入专用容量计划对系统性能进行更深入的控制。OpenAI的专用容量计划在本月早些时候泄露的文件中首次详细说明,该计划今天推出,让客户为运行OpenAI模型的计算基础设施分配付费,例如,gpt-3.5-turbo。(顺便说一句,后端云计算平台是Azure)。

除了对实例负载的 “完全控制”,通常情况下,对OpenAI API的调用发生在共享计算资源上,专用容量使客户有能力启用诸如更长的上下文限制等功能。上下文限制是指模型在生成额外文本之前考虑的文本;较长的上下文限制允许模型从本质上 “记住”更多的文本。虽然较高的上下文限制可能无法解决所有的偏见和毒性问题,但它们可以使gpt-3.5-turbo等模型的“幻觉”减少。

Brockman说,专用容量的客户可以期待gpt-3.5-turbo模型有高达16k的上下文窗口,这意味着他们可以接受四倍于标准ChatGPT模型的tokens。这可能会让人们在粘贴数页的税务代码后从模型中得到合理的答案,比如说,这是今天不可能实现的壮举。

Brockman暗指未来会有一个全面的发布(但不是很快)。

Brockman说:“上下文窗口开始逐渐增加,我们现在只为客户提供专用容量的部分原因是,我们这边有很多性能上的折衷。我们最终可能会提供同样东西的按需版本。”

鉴于OpenAI在获得微软数十亿美元的投资后,面临着越来越大的盈利压力,这并不令人惊讶。

Prev Chapter:Snapchat将发布自己的AI聊天机器人,由ChatGPT提供技术支持

Next Chapter:Apple 在保证内容审核后批准了 ChatGPT 驱动的应用程序

评论区

- 这篇文章还没有收到评论,赶紧来抢沙发吧~