清华大学发布的另一个大语言模型UltraChat_tiknovel-最新最全的nft,web3,AI技术资讯技术社区

清华大学发布的另一个大语言模型UltraChat

2023-07-01 16:53:44 浏览:212 作者:管理员

清华大学发布的另一个大语言模型UltraChat

这个和ChatGLM不同,是利用LLaMA+ChatGPT的数据训练的。比较有特色的是训练数据没有用其他公开数据,而是让两个ChatGPT机器人一问一答来生成数据训练。“为了确保生成质量,我们在生成过程中采用了两个独立的ChatGPT Turbo APIs,其中一个扮演用户的角色生成查询,另一个生成响应。我们通过精心设计的提示指导用户模型模仿人类用户的行为,并迭代地调用这两个APIs。生成的对话经过进一步的后处理和过滤。”

地址:github.com/thunlp/UltraChat

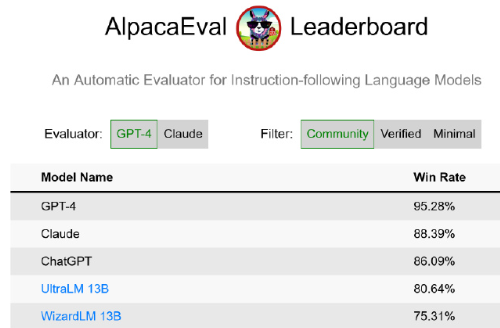

目前在AlpacaEval 排行榜上的开源模型里排第一。

Prev Chapter:人气骤降!ChatGPT访问量增长停滞,AI风口还能延续多久?

Next Chapter:ChatGPT流量见顶 AI革命中道崩殂?或许是OpenAI在下一盘大棋

评论区

共 0 条评论

- 这篇文章还没有收到评论,赶紧来抢沙发吧~