硅谷有了自己的鲁迅!AI大佬LeCun连续暴走,从马斯克到OpenAI,全被怼了个遍_tiknovel-最新最全的nft,web3,AI技术资讯技术社区

硅谷有了自己的鲁迅!AI大佬LeCun连续暴走,从马斯克到OpenAI,全被怼了个遍

当地时间5月26日,马斯克旗下的人工智能初创公司xAI宣布完成B轮60亿美元融资。主要的投资者包括 Valor Equity Partners、Vy Capital、Andreessen Horowitz、红杉资本等。

xAI2023年7月份成立,不到一年时间估值已达240亿美金,是OpenAI(800亿美金)三分之一。融资总额也仅次于OpenAI和Anthropic,正式跨入大模型第一梯队。xAI目前已经发布了Grok1(已开源),Grok-1.5(长上下文理解和高级推理能力)Grok-1.5V(xAI首款多模态大模型)。

另外,马斯克还计划在2025年秋季建成一座“算力超级工厂”为xAI提供算力支持,预计将使用10万块英伟达H100 GPU。

但马斯克的风头却很快被一个人“抢走”。这人就是机器学习之父、图灵奖得主、Meta首席人工智能科学家Yann LeCun。

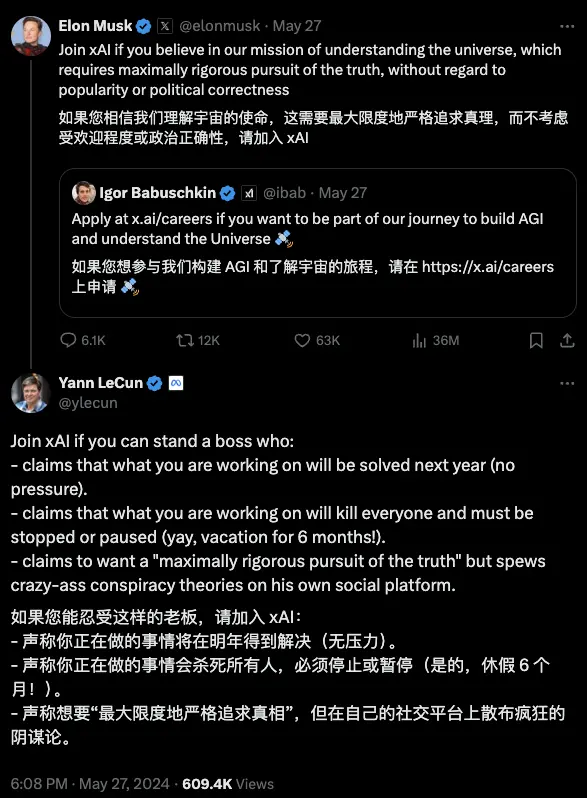

在xAI融资消息披露之后,马斯克顺势在X上发布了一条xAI招聘技术人员的推文:“如果你相信我们的使命是理解宇宙,并且需要最严格地追求真理,不顾及受欢迎度或政治正确性,那么请加入xAI。”

然后Yann LeCun就出来拆台了,语气毫不客气:

他先是迅速回应了马斯克的招聘帖子:“如果你能忍受这样的老板,请加入xAI:声称你正在研究的东西明年就能解决(毫无压力)。声称你正在研究的东西会毁灭所有人,必须停止或暂停(哇,6个月的假期!)。声称要‘最严格地追求真理’,但在他自己的社交平台上散布疯狂的阴谋论。”

LeCun的评论是在讽刺马斯克此前的言论。今年四月份,马斯克声称通用人工智能将在明年到来,以及马斯克上周在“欧洲科技创新展览会”上重申的这一预测,并认为AI有10-20%的可能性会摧毁人类的言论。

而“六个月的休假”指的是马斯克等人曾在去年3月发布要求暂停AI开发6个月的联名信说。Lecun在当时就对此表示反对:“今年是1440年,天主教会呼吁暂停使用印刷机和活字机6个月。想象一下,如果平民获得书籍,会发生什么?他们可以自己阅读圣经,社会就会被摧毁。”

最后,这位“AI教父”还讽刺了马斯克在X平台上分享未经证实的言论行为。

在评论区马斯克和LeCun继续“对线”,双方言辞都相当激烈:

先是网友问LeCun为什么不创办自己的AI公司,而是留在Meta还喷别人。

LeCun回复说我是科学家,不是商业或产品领域的人士。

马斯克灵魂拷问:那过去五年你在“科学领域”都做了啥?

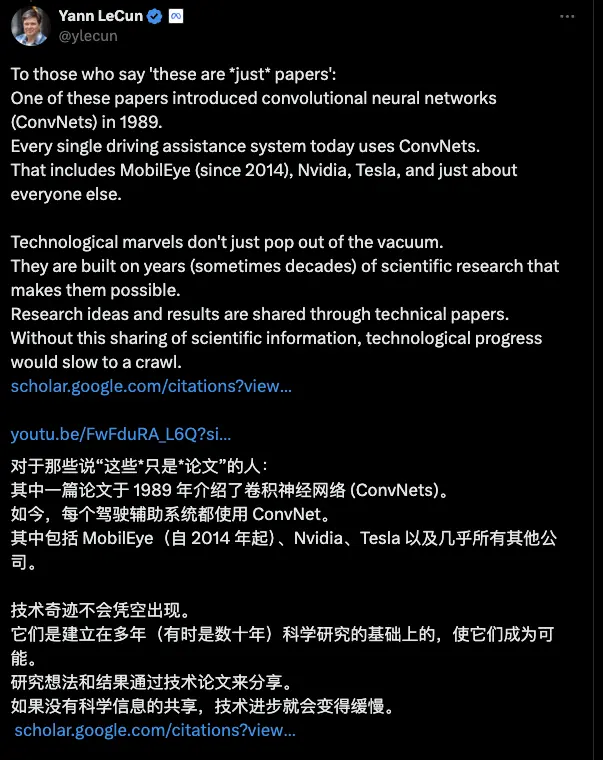

LeCun说自己“发了80篇Paper”还带上Scholar主页。

马斯克继续回怼:“这算啥,你太松懈了,你得支棱起来啊。”

LeCun也不示弱:“说的你好像是我老板。”

LeCun还反驳了那些轻视学术论文观点,作为“卷积网络之父”,他举例说明卷积神经网络(ConvNets)这一在1989年由学术论文引入的技术,已经成为当今几乎所有驾驶辅助系统的核心组成部分。

他进一步强调,技术奇迹并不是凭空出现的,而是建立在多年甚至数十年的科学研究基础之上的。科学研究的想法和成果通过技术论文的形式被分享出来。没有这种科学信息的共享,技术进步将会大幅放缓。

在AI监管问题上,LeCun和马斯克的观点也不一致,前者一直反对过度监管AI,主张AI的开放性和共享性,反对过度的监管限制,两人这次也在这个话题上再次交锋。

LeCun在X上表示目前无需过度担忧AI风险问题,进行监管也为时过早。

马斯克回复:准备好被监管吧。还配上了一个笑哭的表情。LeCun则阴阳了马斯克一句:你对“不要训练超过10^26flops的模型”感到高兴吗?

这是指拜登去年10月签署的关于人工智能的行政命令,要求使用具有10^26 FLOPS能力的模型的公司向美国政府报告基础模型训练运行和部署的计划,而马斯克一直在积极呼吁要立法人工智能监管。

句句扎心,LeCun简直成了硅谷自己的鲁迅。

Lecun:AI末日论者都别跑

而这也不是这位硅谷鲁迅第一次在互联网上和人针锋相对。

他时常因其直言不讳的风格在网上引发了讨论和争议,尤其是关于AI安全。LeCun对AI末日论持有明确的反对态度,并且对开源和人工智能的未来持乐观态度。

LeCun多次在公开场合和访谈中表示,AI毁灭人类的概率为零,认为 AI 末日论是无稽之谈。并且LeCun似乎会主动找机会,“喷”任何持AI末日论观点的人。

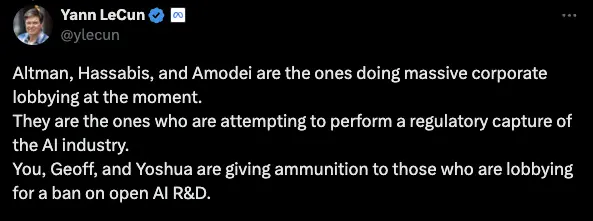

在Geoffrey Hinton携手一众大神关于AGI风险治理的声明,Lecun没有署名,并且直接在X上点名了Sam Altman和DeepMind的Hassabis等人,认为他们试图通过游说监管来巩固自己的行业地位,阻碍开放AI推进。

最近一段时间热议的OpenAI超级对齐团队人员离职,引发对AGI安全问题的隐忧的事件中,LeCun也没有缺席。

先是OpenAI首席科学家兼联合创始人Ilya Sutskever在宣布离职,同一天,“超级对齐”团队的另一名负责人Jan Leike也宣布离开了OpenAI,并表示OpenAI在过去的几年里安全文化和流程被抛到了一边,让位于打造产品,OpenAI必须成为一家安全第一的AGI公司。

马斯克随后进补了一刀:言外之意就是说安全并不是OpenAI的首要任务。

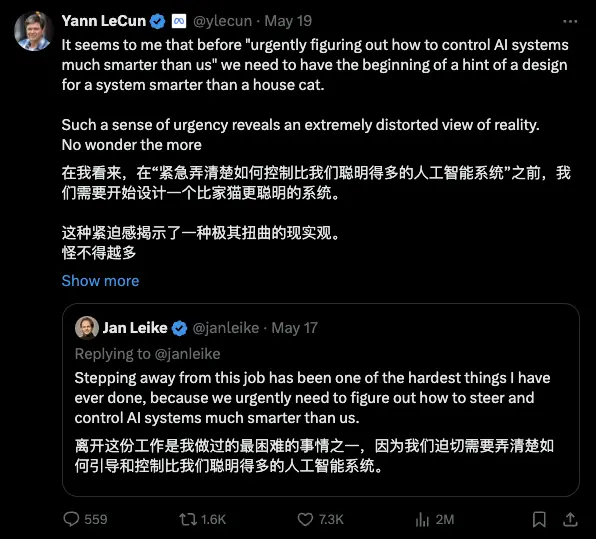

LeCun也再次出来唱反调,表明了他对AI安全问题的立场:

在LeCun对Jan Leike对回复中,他表示当前对AI安全担忧的紧迫感是过度夸张的,类似于在涡轮喷气发动机发明之前,急于解决跨洋飞行的安全问题。所以也难怪OpenAI会边缘化对齐团队。

在他看来,当前的AI还不如猫智能,我们首先需要设计出比家更聪明的系统。并提到,就像飞机技术的发展一样,智能系统的进化需要多年时间,应该通过反复的工程改进逐步提高其智能和安全性,而不是过度担忧未来可能的风险。

关于AI安全和治理问题,Yann LeCun此前与另一位人工智能先驱Yoshua Bengio在网上也进行过激烈辩论。LeCun呼吁信任人工智能可靠性的AI科学家和工程师发声,而Bengio强调开放源AI平台的潜在风险,以及安全和治理的重要性。两人的辩论反映了AI研究者之间对AI潜在风险、现有安全措施的有效性和未来发展路径的重大分歧。

LeCun认为,与其想象灾难性的场景,不如专注于设计安全的AI系统。他相信,通过正确的设计和工程方法,AI系统可以变得安全和可靠。他认为已经有大量的资金投入到确保AI系统安全和可靠的工作中,这表明行业内对AI安全的重视和努力。LeCun强调,AI的设计初衷是为了增强人类智能,而不是造成伤害。他不同意将AI系统比作武器的观点,认为这样的类比是不恰当的。

大语言模型无法通向AGI,不要浪费时间

虽然Meta推出了开源大型语言模型Llama,但Yann LeCun作为Meta的首席人工智能科学家及FAIR(Facebook AI Research)负责人,对LLM的不看好却是尽人皆知。

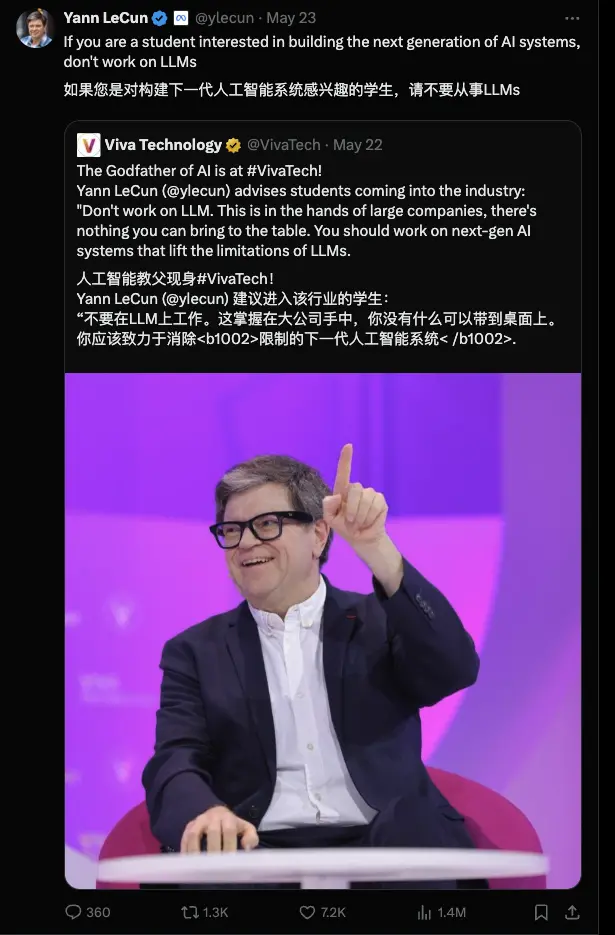

他最近还直接对学生喊话:如果你对下一代人工智能系统感兴趣,不要研究大型语言模型。

在近日与英国《金融时报》的一次访谈中,他反对依赖不断发展的 LLMs 来追求人类级别的智能,因为这些模型只有在被输入正确的训练数据时才能准确回答问题,因此“本质上是不安全的”。

谷歌DeepMind还花了几年时间寻找构建AGI的替代方法,包括强化学习等方法,其中人工智能代理在类似游戏的虚拟环境中从周围环境中学习。

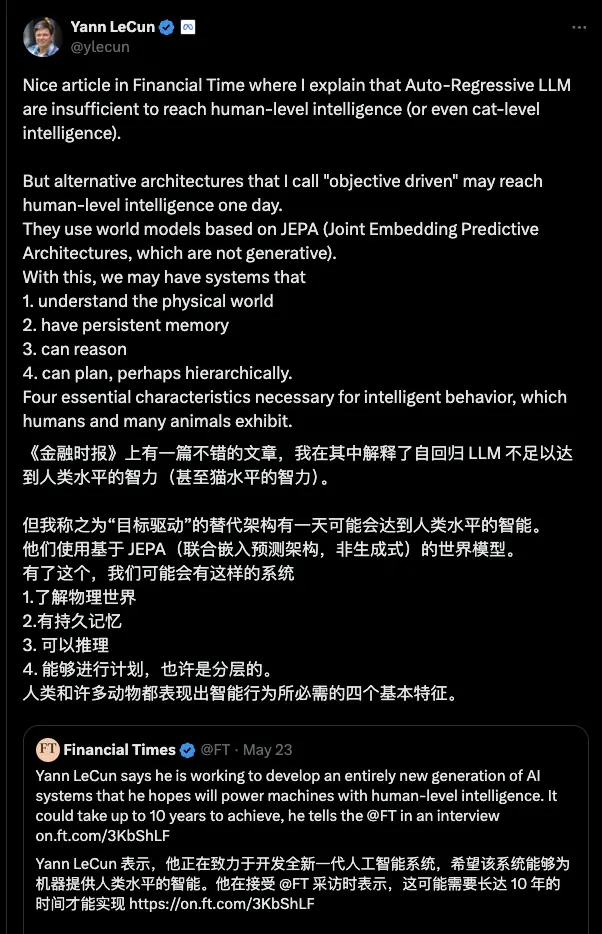

所以他转而专注于一种根本性的替代方法,正在努力开发一个全新的AI系统,希望这些系统能够为机器提供人类级别的智能,尽管他表示这一愿景可能需要10年才能实现。

LeCun认为,LLM的自回归性质(根据之前的单词预测下一个单词)从根本上限制了它们实现真正智能的能力。他主张联合嵌入预测架构 (JEPA) 作为一种更有前景的AGI方法。LeCun还批评了当前对基于文本的学习的关注,认为需要观察物理世界并与物理世界互动,以建立对规划和推理至关重要的全面世界模型。

他强调感官输入以及与物理世界的互动对于发展真正的智力的重要性。他指出,接受过大量文本数据训练的LLM缺乏像人类和动物那样推理、计划和理解世界的能力。LeCun建议未来的人工智能系统需要:

1、结合感官输入以更深入地了解世界。

2、与基于文本的学习相比,以更高的带宽处理信息(例如,人脑以每秒约 20 兆字节的速度处理视觉信息)。

3、立足现实,拥有经验知识,展现常识推理。

李飞飞近日和斯坦福哲学教授Etchemendy在《时代(Time)》上刊载文章,指出当前技术路线无法制造有感知能力的AI,该文章也得到了LeCun的转发支持。

尽管Llama最初是由LeCun领导的FAIR开发的,但现在已经转交给了专注于技术和产品开发的GenAI部门,FAIR则专注于更长远的目标:开发能够达到人类智能水平的新AI架构和方法。

许多人认为Yann LeCun喜欢发表一些争议言论,但更重要的背景是目前AI未来发展中产生的问题。作为人工智能领域最知名的人士之一,Yann LeCun在某种程度上有义务站出来,为这个充满争议的领域提供一些清晰的见解。

LeCun说,实现AGI不是一个产品设计问题,甚至不是一个技术开发问题,在很大程度上是一个科学问题。

如果这个说法是成立的,那么在通往探索AGI的道路上,显然我们需要更多他这样的“鲁迅”。

Prev Chapter:欧科云链研究院:香港虚拟资产ETF背后的安全之道

Next Chapter:多家虚拟货币平台撤回香港牌照申请️

评论区

- 这篇文章还没有收到评论,赶紧来抢沙发吧~

【随机内容】

-

Unrivaled Medicine God Chapter 1692 - Golden Sword Pact!

2024-11-20 -

Reincarnation Of The Strongest Sword God Chapter 886 - Guild Legacy

2024-11-14 -

2024-11-13

2024-11-13

-

2023-05-23

2023-05-23