曝Reddit屏蔽多个搜索引擎和AI爬虫,官方称与谷歌合作无关

7 月 25 日消息,今年 2 月,谷歌宣布与 Reddit 达成一项新协议,Reddit 数据将用于训练谷歌的 AI 模型,并在谷歌搜索结果中着重显示 Reddit 结果。彭博社报道称,这笔交易的金额约为 6000 万美元。从那时起,Reddit 在谷歌搜索中的展示次数也大幅增加。

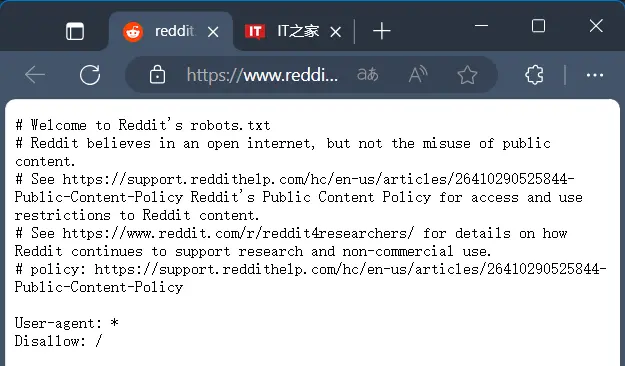

而最新消息称,Reddit 已禁止其他搜索引擎检索其网站内容。外媒 404 Media 最先报道了此行为,并指出 Reddit 已更新其 robots.txt 文件(IT之家注:网站与爬虫的协议文件),阻止所有机器人抓取网站的任何内容。

IT之家查询 Reddit 网站的 robots.txt 文件获悉,该平台称“Reddit 相信开放的互联网,但不相信滥用公共内容。”其“Disallow”选项设置为“/”,也就是禁止检索网站根目录下的所有文件。

该文件在今年 6 月首次更新,Reddit 解释说,这一更改是由于“抓取 Reddit 内容的商业实体明显增多并且内容被滥用”。

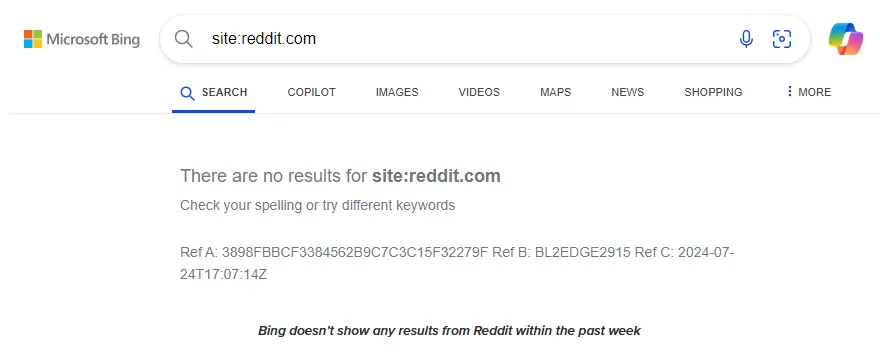

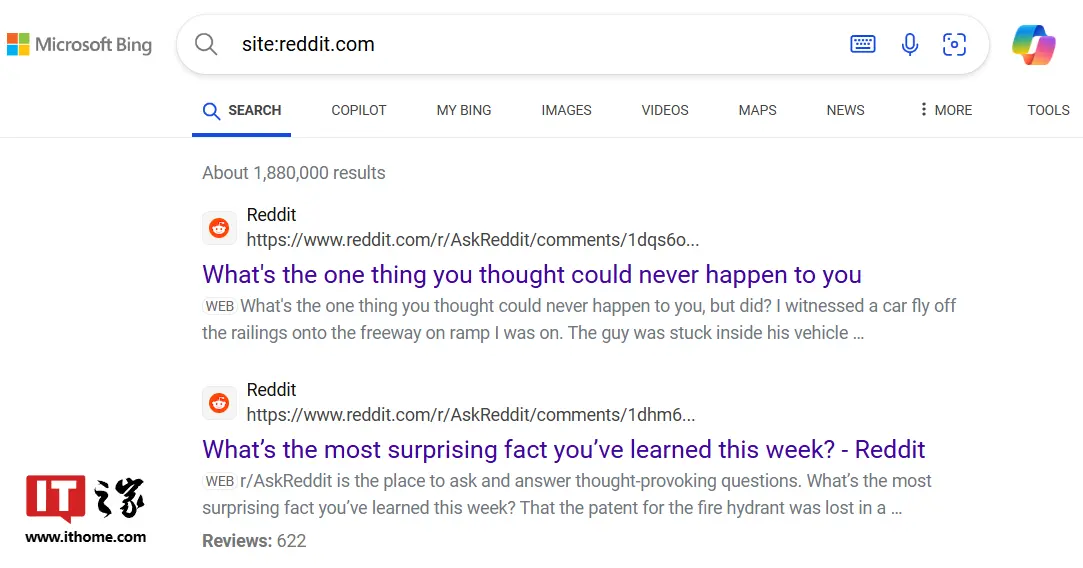

外媒 9To5Google 则称,Bing、DuckDuckGo、Mojeek 和 Qwant 等搜索引擎都受到了影响,使用“site:reddit.com”搜索内容时,要么不显示最新内容,要么不显示完整的网站结果。

不过IT之家最新测试,Bing、DuckDuckGo 已重新显示“site:reddit.com”搜索内容。

Reddit 发言人 Tim Rathschmidt 在给 The Verge 的一份声明中表示:“这与我们最近与谷歌的合作完全无关。我们一直在与多个搜索引擎进行讨论,但无法与所有人达成协议,因为有些人无法或不愿意就他们使用 Reddit 内容(包括他们对 AI 训练的使用)作出可执行的承诺。”

相关内容

- 2024-12-20 AI也会得老年痴呆!最新研究:AI版本越老越糊涂

- 2024-12-19 传AI集成到苹果iPhone 腾讯大涨4% 字节概念股涨停

- 2024-12-19 AI创企暴雷!90后女创始人欺诈被捕:涉案7000万,或面临40年刑期

- 2024-12-19 AI成“吞电巨兽”!美监管机构警告:部分地区最早明年将电力短缺

- 2024-12-19 刚刚,AI颠覆物理模拟:一句话精准仿真,学术圈半壁江山联手耗时24个月研究成果

点击排行

- 105-17OpenAI多位重量级高管离职,质疑再次涌向Sam Altman

- 203-07ChatGPT-Plus,AI 助手全套开源解决方案,自带运营管理后台,开箱即用。

- 306-22RTranslator: 全球第一个开源实时翻译应用程序

- 410-18诺奖得主哈萨比斯最新访谈:仅仅将AI视作一种技术是错误的

- 505-17马斯克称OpenAI最新模型慢得离谱

- 606-23OpenAI CTO:GPT-5可能会在2025年底或2026年初推出

- 706-23企业家自曝用了ChatGPT后裁员近1/10:管理效率大幅提升

- 805-17GPT-4o被全球网友玩坏了 谷歌:终究是错付了

- 906-23高通开放AI模型,助力开发者打造骁龙X Elite平台智能应用

- 1005-17谷歌Gemini AI 计划为学校提供额外的数据保护和隐私