AGI渐行渐近,该加速还是要踩刹车?_tiknovel-最新最全的nft,web3,AI技术资讯技术社区

AGI渐行渐近,该加速还是要踩刹车?

马斯克在今年早些时候预测,AGI可能会在2026年投入使用。DeepMind联合创始人、首席AGI科学家Shane Legg在一次访谈中认为,2028年,人类有50%的概率开发出第一个AGI。然而百度CEO李彦宏的观点则更加审慎,他认为AGI还需要10年以上的时间才能出现。

自1956年达特茅斯会议提出“人工智能”这一概念以来,实现人类水平的智能一直是AI领域的圣杯。去年上半年,有主流研究者提出,大语言模型已经表现出“通用人工智能的火花”(sparks of AGI)。

这似乎表明,AGI已经从哲学猜想变成了将来的未来。然而,关于AGI的观点众说纷纭,大语言模型也常有愚蠢行为出现,这些都引发了对AGI的质疑。

在此背景下,我们离实现真正的AGI还有多远?如何预防AGI带来的潜在风险?

AGI,未到的黎明

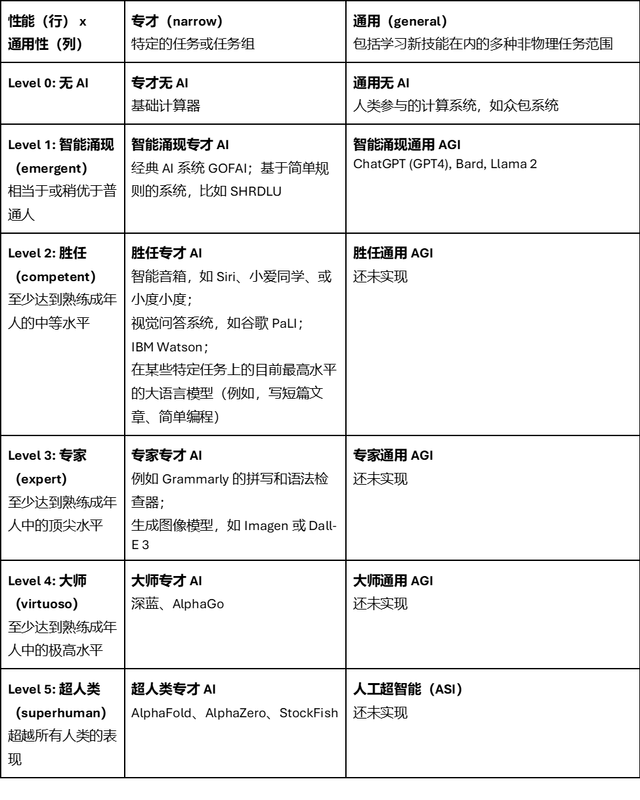

从性能强度和通用性两个维度,可以将人类和AI的关系划分为6个阶段:无AI、智能涌现、胜任、专家、大师、超人类。而现在大语言模型的出现,正属于第一个AGI的阶段:AGI雏形。

AGI(Artificial General Intelligence),即通用人工智能,其目标是实现人类般的通用智能,这意味着AI可以像人类一样理解任意通用任务,并以人类的智力水平执行完成。基本上,除了“自我意识”的生成,AGI就是人类对人工智能的终极梦想了。

AGI是要让智能体像人一样,不仅能够独立感知环境、进行思考、作出决策、学习新技能、执行任务,还能够与人类或其他智能体进行有效的协作。同时,智能体能够理解人类的情感,并且遵循社会伦理和道德规范。

一个完整的AGI需要具备三个基本特征:第一,必须能完成无限的任务,而不是只能完成人定义的有限几个任务。第二,要在场景中自主发现任务,这是通常所说的要做到“眼里有活儿”。第三,要有自主的价值来驱动,而不是被动的被数据所驱动。

同时,AGI还需要解决一些关键的技术问题,比如构建智能体的认知架构,让智能体由价值驱动,在现实世界中进行有效的行动,能够与社会环境进行互动,使智能体决策过程透明可解释,以及建立和人类之间的信任关系等。

以OpenAI的ChatGPT、谷歌Bard、Meta的Llama为代表的大模型,已经在通用性上展示出了AGI的潜力。因为大语言模型已经能完成范围相当广的各类任务,而且表现出了像学习新技能这样的“元认知”能力。

相比大模型的“鹦鹉范式”,AGI是以“小数据,大任务”为架构的“乌鸦范式”,智能体表现为具有自主的智能,能够自主感知、认知、推理、学习和执行,不依赖于大数据,基于无标注数据进行无监督学习,并且智能系统低功耗。就像乌鸦喝水这一行为,看似简单,却属于自主推理行为,是由价值与因果驱动的高级智能,也是AI的未来发展趋势。

如果单从AI的性能维度上看,“窄AI(Narrow AI)”类型的AI已经达到了完全超越人类认知的水平。以AlphaFold、AlphaZero为代表的专业领域AI,在特定领域已经能发现人类智力无法发现的新事物了,此类被成为“超人类窄AI”。而在某些领域,AI能达到90%的人类水平,比如文书纠正AI Grammarly,DALL·E 2,Imagen等生图AI,这被称为“专家级窄AI”。在特定领域,能达到普通人的平均水平,比如Siri,谷助手这类普通智能助理,其被称为“普通窄AI”。

所谓“窄AI”,是指那些特别擅长处理单一任务或者特定范围内工作的系统。在大多数情况下,它们在特定领域中的表现远优于人类。不过一旦它们遇到的问题超过了适用空间,效果则急转直下。换言之,它们无法将自己掌握的知识从一个领域转移到另一个领域。

尽管窄AI无法全面执行需要人类智能的任务,但在特定场景中仍然非常实用,而且已经在诸多应用之内发挥着自己的作用。谷歌搜索查询现在可以利用窄AI算法回答问题,窄AI系统会在YouTube及Netflix中推荐用户可能感兴趣的视频,并在Spotify中按喜好整理出周推音乐列表。

而在窄AI已经覆盖的能力维度上,AGI都还没有出现对应的实例,因为目前还没有出现真正意义上的AGI,对于AGI的定义,人类也还没有达到统一的认知。

谁会是AGI的起点?

从信息时代走向智能时代,“语言”成为那把开启全新时代的钥匙。著名的作家兼哲学家路德维希·维特根斯坦在其《逻辑哲学论》一书中提到:“我的语言的界限,意味着我的世界的界限。”

对人类而言,承载世界的知识、思考、沟通和文化靠的是语言。语言本身的发明代表着每多一个词汇就让世界多了一个认知维度,词汇之间建立的逻辑关系和表达代表了人类对世界完整的建模。这个模型不是在图像里面,而是通过语言进行承载,所以语言边界就是世界边界。AI核心就是把现实世界的现象翻译成为数学模型,通过语言让机器充分理解现实世界和数据的关系。

如今,人们已经走出了原来物理学靠一个公式解释世界的方法,更多是靠海量数据在不同层次单独建模,上层建模就是由大量的数据驱动。语言模型如此,生命建模也是如此,2021年最伟大的成就就是DeepMind的AlphaFord系统,针对基因到蛋白质的三维结构建模,通过这个模型预测基因被转录或者表达为蛋白质以后拥有的形态,也是全世界轰动的生命领域的突破,靠的也是数据和AI的驱动。

虽然大模型已经取得了一些惊人的进展,但如果比较AGI的三个特征,就会发现大模型还不符合AGI的要求。

首先,大模型在处理任务方面的能力有限,它们只能处理文本领域的任务,无法与物理和社会环境进行互动。这意味着像ChatGPT这样的模型不能真正“理解”语言的含义,因为它们没有身体来体验物理空间。

其次,大模型也不是自主的,它们需要人类来具体定义好每一个任务,就像一只“鹦鹉”,只能模仿被训练过的话语。真正自主的智能应该类似于“乌鸦智能”,能够自主完成比现如今AI更加智能的任务,当下的AI系统还不具备这种潜能。

第三,虽然ChatGPT已经在不同的文本数据语料库上进行了大规模训练,包括隐含人类价值观的文本,但它并不具备理解人类价值或与人类价值保持一致的能力,即缺乏所谓的道德指南针。

但这并不妨碍科技巨头对于大模型的推崇。OpenAI、谷歌在内的科技巨头,都将大模型视为迈向AGI的关键一步。OpenAI CEO Sam Altman就曾多次表示,GPT模型是朝着AGI方向发展的重要突破。

不过,Meta人工智能首席科学家杨立昆(Yann LeCun)认为,目前的大模型路线无法通往AGI,且非常危险。

他指出,现有的大模型尽管在自然语言处理、对话交互、文本创作等领域表现出色,但其仍只是一种“统计建模”技术,通过学习数据中的统计规律来完成相关任务,本质上并非具备真正的“理解”和“推理”能力。

他认为,“世界模型”更接近真正的智能,而非只学习数据的统计特征。以人类的学习过程为例,孩童在成长过程中,更多是通过观察、交互和实践来认知这个世界,而非被单纯“注入”知识。而LeCun的“世界模型”路线,则是试图通过对视频、音频等媒体的模拟与补全,让AI也经历这样一个自主学习的过程。

他也承认,实现“世界模型”并非易事,这一雄心勃勃的目标可能需要耗时10年才能实现。

将风险控制在可控范围内

对于AGI所带来的风险,图灵是最早提出警告的人之一。他在1951年说道:“一旦机器开始思考,很快就能超越我们。因此,在某个时候,我们应该期望机器能够被掌控。”因为当一个比人类更强大的智能体出现时,人类很难维持权力,特别是当这些智能体具有不正确或不完整的目标时。

如果还有人认为现在考虑这些风险是危言耸听,那么如何回答这样一个问题:你如何在比人类更强大的智能体面前永远保持权力?此外,在AI领域,还有一些人试图回避这个问题,否认AGI的可实现性,却没有提供任何证据。

OpenAI CEO Sam Altman在其文章《Planning for AGI and Beyond》里,探讨了AGI对社会、技术和伦理的潜在影响,并强调了慎重规划和负责任的发展的必要性。

文章指出,通过增加资源丰富度、推动全球经济增长,以及助力新科学知识的发现,AGI有潜力极大地提升人类生活质量。这不仅是智力的巨大增幅,更是对人类创造力和想象力的极大扩展。

然而,AGI的出现也可能带来严重的滥用风险、意外极端事件的可能以及对社会结构的剧烈动荡。因此,OpenAI提倡在发展AGI时,AGI开发者以及全社会都必须找到正确的方法来实现和利用这一技术,确保其与人类核心价值观保持一致,并公平地分享其带来的好处。

此外,OpenAI认为,从长远来看,AGI的出现仅仅是智力发展的一个节点,而AI的进步可能会在未来相当长一段时间内继续保持。OpenAI提出了一个安全的AGI发展愿景,即在较短时间内以较慢的速度过渡到AGI,以便社会有时间适应和调整。

尽管未来不可预知,但OpenAI表达了他们最关心的几个原则:希望AGI能最大限度地促进人类在宇宙中的繁荣;希望AGI带来的好处、访问权和治理能够被广泛且公平地分享,并成功应对巨大风险。

为此,OpenAI倡导在短期内进行渐进式过渡、继续创造越来越符合目标的模型,并在长期进行全球范围的对话,讨论如何治理这些系统、如何公平分配它们产生的好处,以及如何公平分享访问权。在极高的风险和回报下,人类需要团结起来,让AGI在未来世界以一种对人类最有益的方式绽放。

对于如何预防AGI给人类带来威胁,可以逐步放开AGI的能力空间和价值空间,一开始把它关在“笼子”里,慢慢打开权限。

对于AGI,可以先其适用场合和行动空间限制在特定区域内,随着人们对机器的信任的增加,确认AGI安全可控后,再逐步给予更大的空间。另外,应该进一步促进算法决策过程的透明度。如果能够清晰了解AGI的认知架构,从而知道其是如何工作的,就能更好地控制它。

人类对于AGI的探索和思考才刚刚开始,我们还有很长的路要走。AGI的进步不仅代表了技术创新,更是对未来人机交互方式的重新想象。随着我们逐步走向AGI未知领域,稳健和有序的发展显得更加重要,我们必须高度警醒AGI所带来的问题,并充分重视AGI所创造的机会。两千多年前,苏格拉底说“认识你自己”,今天在AGI技术发展的倒逼下,人类需要“重新认识你自己”。

Prev Chapter:OpenAI联合创始人Greg最新采访:为什么OpenAI最先做出GPT-4?

Next Chapter:OpenAI罢免闹剧水落石出:奥特曼被驱逐原因公布

评论区

- 这篇文章还没有收到评论,赶紧来抢沙发吧~

【随机内容】

-

lord of the mysteries Chapter 342 - The Old Fox Alger

2024-11-16 -

2024-05-10

2024-05-10

-

Myriad Paths of the Dragon Emperor Chapter 2814 - Chapter 2814: Chapter 2814-demon

2024-11-21 -

2022-06-14

2022-06-14